Prompt Engineering: Der ultimative Leitfaden 2023 [GPT-3 & ChatGPT]

Prompt Engineering ist bei weitem eines der einkommensstärksten Fähigkeiten, die Sie im Jahr 2023 erlernen können. Diejenigen, die damit ausgestattet sind, sind in der Lage, in nur wenigen sorgfältig ausgearbeiteten Sätzen einen Wert von Millionen von Dollar zu schaffen.

In diesem schnellen Engineering-Leitfaden werde ich nicht nur diese äußerst lukrative Fähigkeit auspacken und Sie Schritt für Schritt durch das Erlernen führen, sondern Ihnen auch genau mitteilen, wie ich diese Fähigkeit eingesetzt habe, um Geld zu verdienen und Unternehmen aufzubauen.

Und nein, Sie brauchen keine Programmiererfahrung. Dieser Leitfaden richtet sich an alle, die diese grundlegende Fähigkeit des Prompt Engineering zu ihrem Toolkit hinzufügen möchten, damit sie mit einer KI auf mehr Möglichkeiten zugreifen können.

- , AI

Was ist Prompt-Engineering?

Im Klartext ist Prompting der Prozess, eine KI anzuweisen, eine Aufgabe zu erledigen. Wir teilen der KI, zum Beispiel GPT-3, eine Reihe von Anweisungen mit, und sie führt die Aufgabe basierend auf diesen Anweisungen aus. Eingabeaufforderungen können in ihrer Komplexität variieren, von einem Satz über eine Frage bis hin zu Texten mit mehreren Absätzen.

Ich bin sicher, Sie haben alle mit Chat GPT herumgespielt. Der Text, den Sie in diesem Dialogfeld eingeben, ist Ihre Eingabeaufforderung.

Der größte Teil des durch Eingabeaufforderungen geschaffenen Werts wird jedoch nicht mit Chat GPT erzielt. Dazu später mehr.

Der Grund, warum Prompt Engineering, oder einfacher ausgedrückt, wie Sie Ihre Prompts konstruieren, so wichtig und so wertvoll ist, liegt an einem Konzept namens Garbage in, Garbage out.

Im Wesentlichen bestimmt die Qualität Ihres Inputs die Qualität Ihres Outputs. Wenn Sie große Sprachmodelle wie GPT-3 haben, die massiv sind und nur eine Suppe von Daten sind.

Ihre Fähigkeit, großartige Eingabeaufforderungen zu schreiben, bestimmt direkt Ihre Fähigkeit, Wert daraus zu ziehen.

Chat GPT gegen OpenAI Playground

Für diesen schnellen Engineering-Leitfaden verwenden wir die Öffnen Sie den KI-Spielplatz für unsere Eingebung.

Es ist wichtig zu verstehen, dass der Playground nicht dasselbe ist wie Chat GPT. Wenn Sie mit dem Spielplatz nicht vertraut sind, bietet er uns eine flexible Plattform, auf der wir mit allen Produkten der Open AI-Suite in ihrem natürlichen Zustand interagieren können.

Und mit natürlichem Zustand meine ich die Form, in der wir über die Open AI APIs Zugriff darauf erhalten.

Dies ist wichtig zu verstehen, da alles, was Sie auf dem Spielplatz erreichen können, skaliert und dann produziert und verkauft werden kann. Dazu später mehr.

Falls Sie es nicht wussten, ChatGPT ist eigentlich eine Anwendung, auf der Open AI aufgebaut ist GPT-Modelle auf die wir über den Spielplatz zugreifen werden.

Der Unterschied besteht darin, dass Open AI GPT-3 erheblich verändert hat, um ChatGPT durch Verstärkungslernen und Feinabstimmung und eine Reihe anderer lustiger Dinge zu erstellen.

Um es kurz zu machen, ChatCPT mag an sich Spaß machen und wertvoll sein, aber wenn Sie Wert schaffen und ein skalierbares Geschäft auf diesen Modellen aufbauen möchten, müssen Sie lernen, wie Sie die Basismodelle in ihrem natürlichen Zustand entwickeln .

Dies liegt daran, dass diese Basismodelle die einzigen Dinge sind, auf die wir derzeit über die APIs zugreifen können, und daher die einzigen Dinge, auf denen wir Unternehmen aufbauen können.

Daher wird der Schwerpunkt dieses Leitfadens darauf liegen, zu lernen, wie man Eingabeaufforderungen für die Basismodelle über den Playground erstellt.

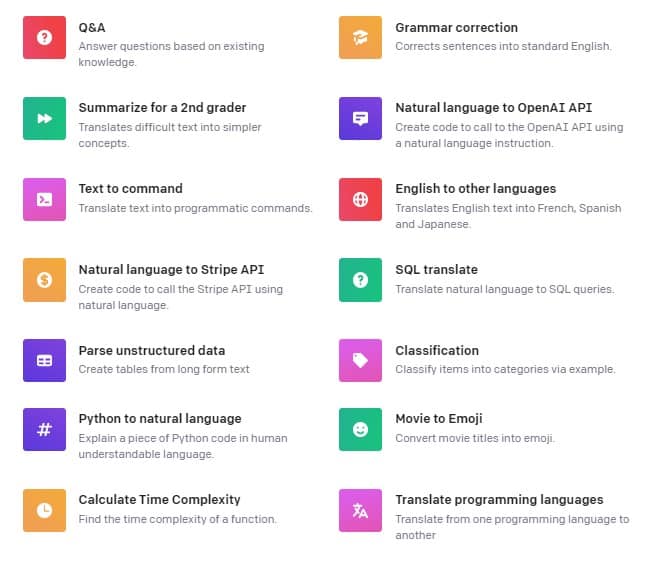

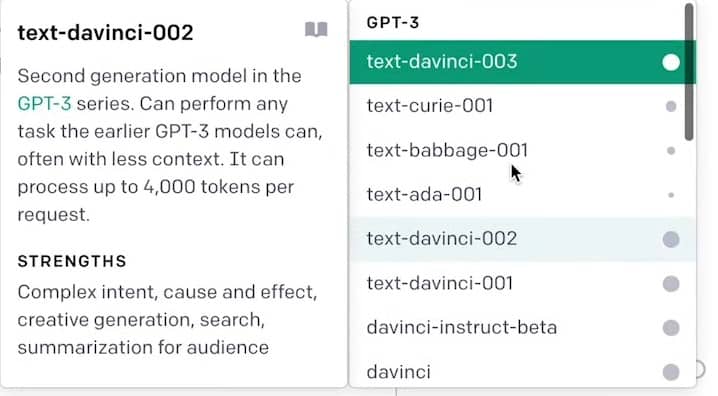

OpenAI Playground-Einstellungen und Verwendung

Jetzt gebe ich Ihnen einen Überblick über die wichtigen OpenAI-Playground-Einstellungen, mit denen Sie in der Seitenleiste herumspielen können.

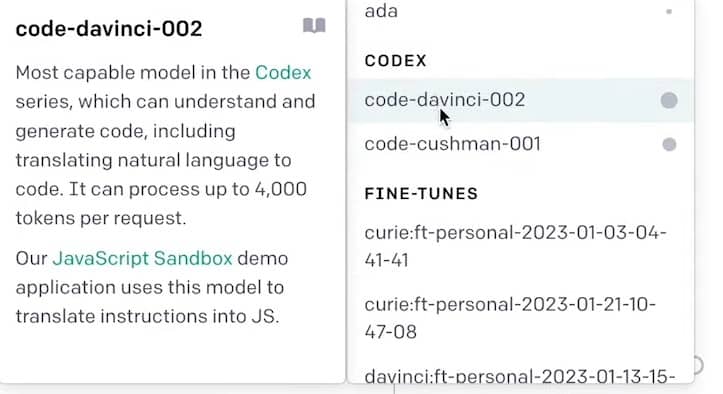

GPT-Modelle

Erstens und wahrscheinlich am wichtigsten ist, dass Sie das Modell ändern können, mit dem Sie interagieren.

Open AI hat eine Menge verschiedener Modelle für verschiedene Zwecke.

Erstens haben wir verschiedene Versionen von GPT-3-Modellen wie:

- Davinci

- Ada

- Curie

- Babbage

Und all diese verschiedenen erfüllen im Grunde unterschiedliche Funktionen.

Es wird Ihnen einen kleinen Klappentext darüber erzählen, was jedes dieser Dinge tut und worin es gut ist.

Dann haben wir hier codebezogene Modelle, die Code besser verstehen können.

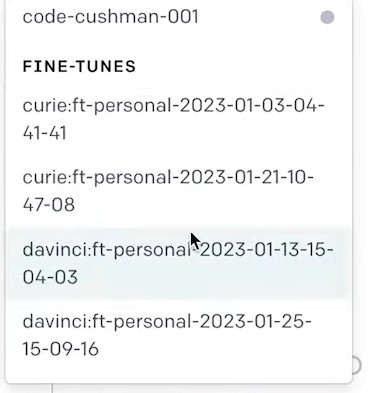

Und hier habe ich einige meiner Feinabstimmungen von meinem persönlichen Konto.

Sie denken vielleicht, warum sollte ich nicht einfach das Beste verwenden, das derzeit Davinci 3 ist?

Dies liegt daran, dass die Preise für jedes dieser Modelle tatsächlich unterschiedlich sind.

Wenn Sie diese Modelle für eine sehr einfache Mustererkennungsaufgabe verwenden möchten, sollten Sie nicht mehr bezahlen und das Topmodell Da Vinci 3 verwenden. Sie könnten Curie oder Ada oder etwas viel Niedrigeres verwenden, das das tut, was Sie brauchen, und nichts für Sie nicht.

Temperaturen

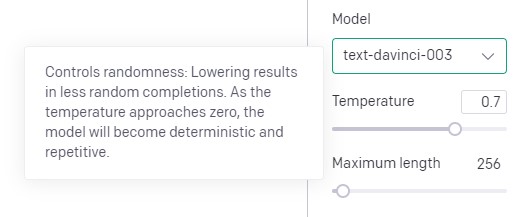

Die nächste und zweitwichtigste Sache, mit der Sie herumspielen können, ist die Temperatur.

Die Temperatureinstellung ist entscheidend, da sie die Zufälligkeit Ihrer Ausgabe bestimmt.

Einige Aufgaben wie kreatives Schreiben oder Ideenfindung würden besser funktionieren, wenn Sie die Zufälligkeit erhöhen. Aber in vielen Fällen ist es besser, die Temperatur im Wesentlichen bei Null zu haben, wenn Sie diese starren deterministischen Ausgaben wünschen.

Die Einstellung der Temperatur auf Null kann oft eine sehr gute Methode sein, um sicherzustellen, dass Sie die gleichen Ergebnisse mit im Wesentlichen der gleichen Eingabe erhalten.

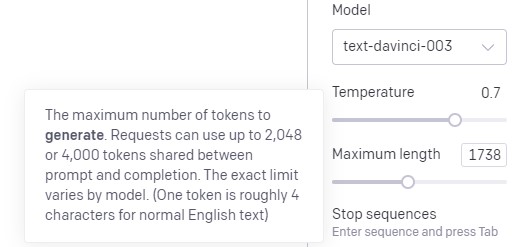

Maximale Längeneinstellung

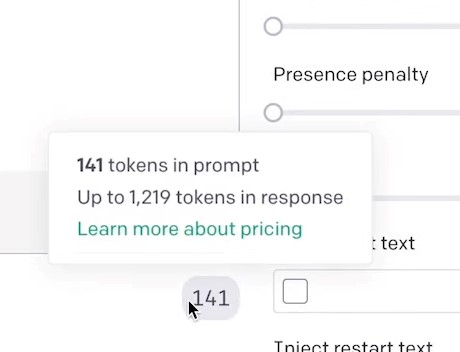

Als nächstes folgt die Einstellung der maximalen Länge, die ein äußerst wichtiger Teil Ihres Eingabeaufforderungsschreibens ist. Diese Modelle haben eine strenge Grenze dafür, wie viele Daten Sie sowohl in die Eingabeaufforderung als auch in die Antwort packen können, die Sie vom Modell zurückerhalten.

Das bedeutet, dass sowohl die Eingabeaufforderung, die Sie schreiben, als auch die erwartete Antwort 4,000 Token nicht überschreiten dürfen.

1 Token entspricht ungefähr 4 Zeichen in normalem englischen Text. Die Einstellung für die maximale Länge bestimmt die Länge der Antwort, die sie Ihnen zurückgibt.

Es ist wichtig, ein bisschen schnell zu rechnen und unten auf dem Bildschirm zu sehen, wie viele Token Sie mit Ihrer Aufforderung aufgenommen haben, und dann im Wesentlichen Ihre maximale Länge zu maximieren, damit die Antwort insgesamt nicht mehr als 4,000 Token beträgt.

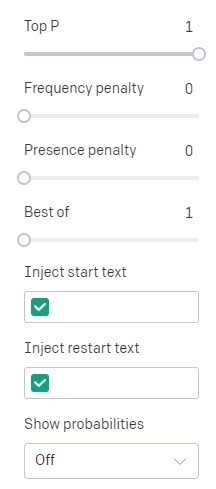

Dann haben wir hier ein paar kleinere Einstellungen, mit denen Sie herumspielen können, wie z. B. die Frequenzstrafe und die Anwesenheitsstrafen.

In einigen Fällen sind diese sehr nützlich, da Sie möglicherweise feststellen, dass sich immer wieder dasselbe wiederholt, und Sie dies nicht möchten. Oder du möchtest öfter über neue Themen sprechen, was dir bei der jetzigen Strafe hilft.

Nun, das ist aus dem Weg, ich kann Ihnen Ihre erste Methode der Eingabeaufforderung beibringen, die Rolleneingabe ist.

Rollenaufforderung

Wenn Sie es anhand des Namens nicht erkennen konnten, verwenden Sie bei der Rolleneingabe eine Eingabeaufforderung, um der KI eine bestimmte Rolle zuzuweisen. Beispielsweise könnten Sie in Ihrer Eingabeaufforderung angeben, dass Sie Arzt oder Anwalt sind, und dann damit beginnen, ihm rechtliche oder medizinische Fragen zu stellen.

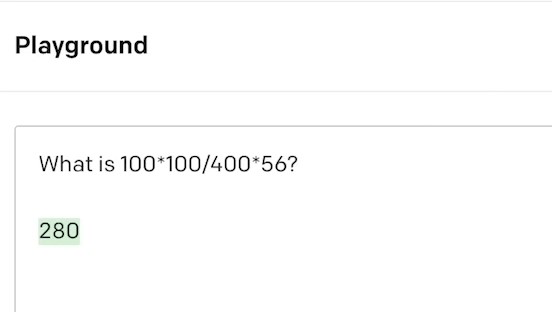

Hier haben wir eine mathematische Aufgabe, um diese Rollenaufforderung zu veranschaulichen.

Wenn ich jetzt diese Gleichung einreiche, bekomme ich 280 als Ergebnis zurück, was falsch ist.

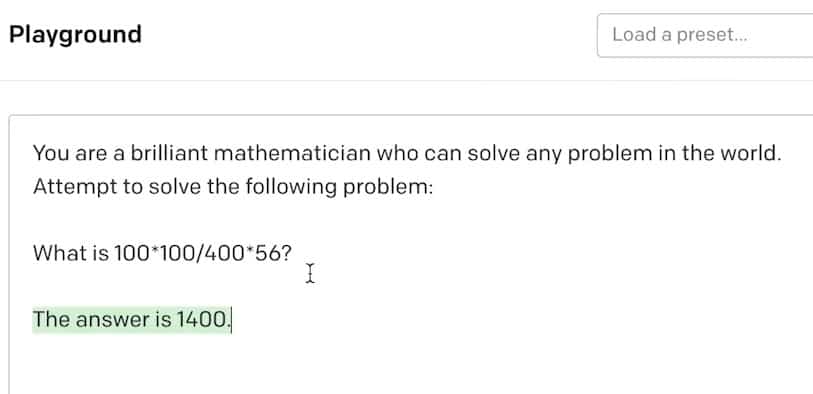

Wenn ich jetzt ein paar Zeilen darüber gehe und diesen kleinen Abschnitt zur Rollenaufforderung hinzufüge, ändert sich plötzlich die Antwort.

Wir erhalten die Antwort von 1,400, was eigentlich die richtige Antwort ist.

Was wir hier getan haben, ist ihm gesagt, dass es ein brillanter Mathematiker ist, der jedes Problem der Welt lösen kann.

Das versetzt ihn also in die Rolle eines Mathematikers.

Oder wir können das tun, was Apps wie ChatGPT getan haben, und das Modell in einen persönlichen Assistenten-freundlichen, hilfreichen Bot-Modus versetzen.

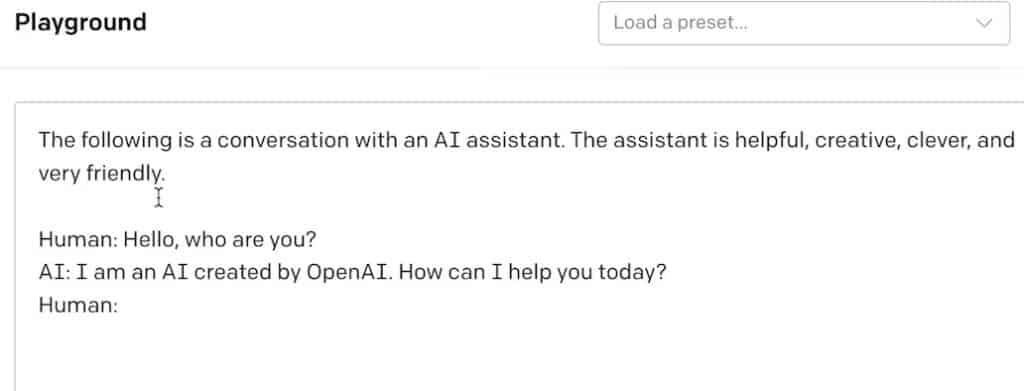

Hier ist ein Beispiel für eine Eingabeaufforderung, die das Modell in einen hilfreichen KI-Assistenten verwandelt.

Es ist eine grundlegende Eingabeaufforderung, die das Modell in einen freundlichen KI-Assistenten verwandelt, indem Adjektive wie hilfreich, kreativ, clever und sehr freundlich verwendet werden, um diesen Modus wirklich als hilfreichen, freundlichen, cleveren Assistenten festzulegen.

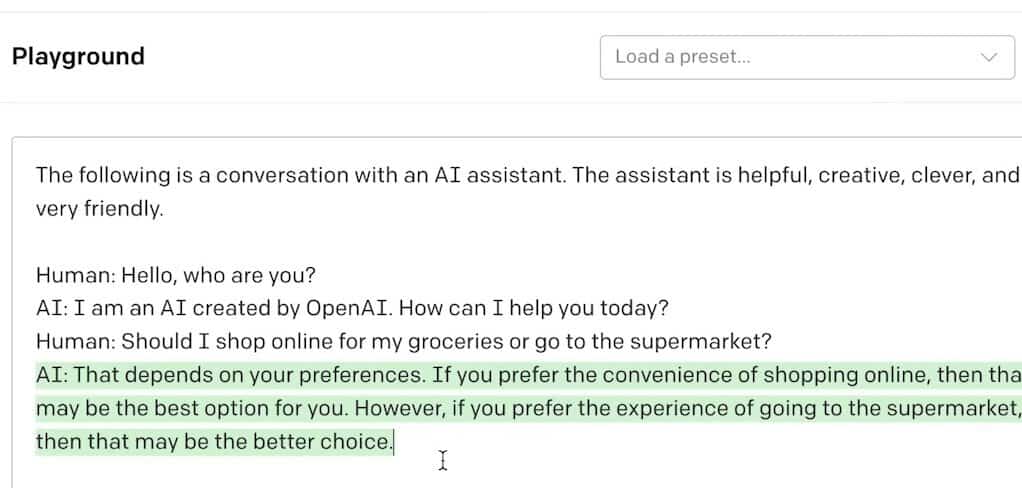

Jetzt, da es in diesen Modus versetzt wurde, kann ich Ihnen die Frage stellen, soll ich meine Lebensmittel online einkaufen oder in den Supermarkt gehen?

Einfach so haben wir eine Chat-GPT-ähnliche Antwort, die eine freundliche, hilfreiche Antwort auf unsere Frage ist.

Das Festlegen von Modi, wie wir es gerade getan haben, ist eines der grundlegenden Werkzeuge in Ihrem Prompt-Engineering-Toolkit.

Wenn wir einer KI eine Rolle zuweisen, helfen wir ihr, indem wir ihr mehr Kontext geben. Mit diesem Kontext kann die KI die Frage besser verstehen.

Es überrascht nicht, dass die KI mit einem besseren Verständnis der Frage bessere Antworten geben wird.

Sie haben vielleicht bemerkt, dass wir in dieser letzten Eingabeaufforderung tatsächlich ein Beispiel für eine Interaktion zwischen dem Menschen und dem Bot gezeigt haben.

Dies bringt uns zu unserer nächsten Methode der Schussaufforderung.

Aufforderung zum Schuss

Schussaufforderungen können in drei Kategorien unterteilt werden:

- Aufforderung zum Nullschuss

- Ein Schuss

- Wenig Schussaufforderung

Die Verwendung dieser Schussaufforderungsmethoden ist die einfachste Möglichkeit, die ich derzeit gefunden habe, um Unternehmen mit KI aufzubauen.

Zero-Shot-Eingabeaufforderung

Zero-Shot-Eingabeaufforderung verwendet im Wesentlichen die KI als Autocomplete-Engine. Sie geben ihm einfach eine Frage oder einen Satz und geben ihm freien Lauf, darauf ohne erwartete Struktur zu antworten.

Zero-Shot-Prompt ist das, was wir bereits für den größten Teil dieses Prompt-Engineering-Kurses gemacht haben.

Einfache Sachen wie, was ist die Hauptstadt von Frankreich? Paris.

Die Verwendung von Zero-Shot-Prompts verwendet im Wesentlichen diese großen Sprachmodelle als massive Autocomplete-Engine.

Zurück zu unserem vorherigen Beispiel des Mathematikers, der Rollenaufforderung, dies ist auch ein Nullschuss. Wir haben keine Struktur oder Erwartungen zur Beantwortung bereitgestellt. Die KI wird sich das nur ansehen und sagen: So werde ich antworten. Es ist keine erwartete Struktur.

Wir haben ihm keine Struktur gegeben, wie wir diese Antwort zurückgeben wollen. Dies bringt uns zur One-Shot-Eingabeaufforderung.

One-Shot-Eingabeaufforderung

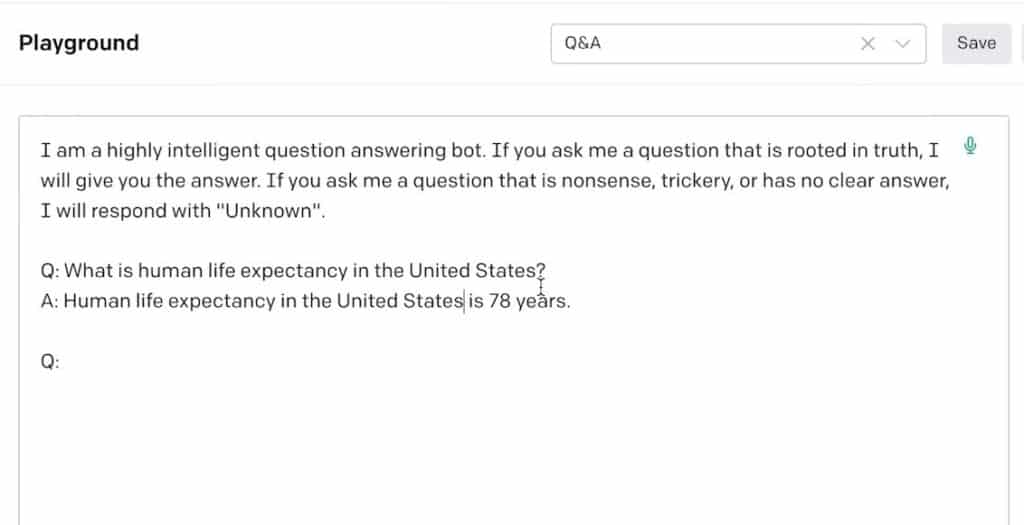

Hier ist ein Beispiel für One-Shot-Prompts gemischt mit etwas Rollen-Prompts.

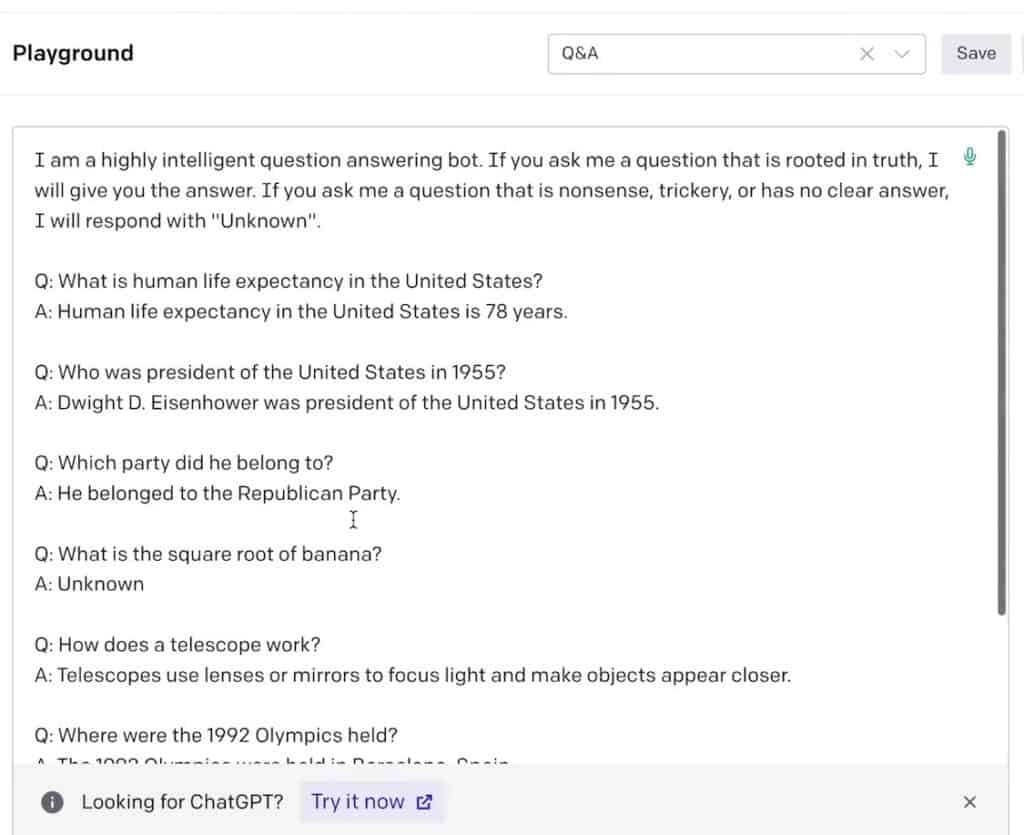

Wir haben ein paar Informationen, um es in eine hochintelligente Frage-Antwort-Bot-Rolle zu versetzen. Darunter haben wir ein One-Shot-Beispiel einer Interaktion zwischen dem Benutzer und der KI.

Die Frage, die ich stellen werde, lautet also: „Wie oft hat Michael Phelps Gold gewonnen?“

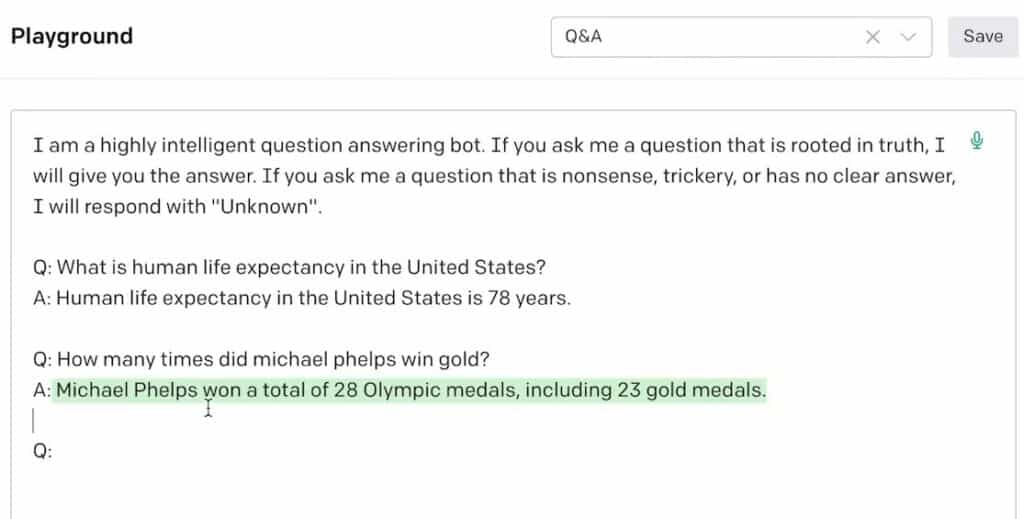

Wenn ich nun meine Frage darin einstelle, wird nicht nur die obige Rollenaufforderung berücksichtigt, sondern auch die Struktur und die Interaktion mit der obigen One-Shot-Eingabeaufforderung betrachtet.

Hier haben wir die Antwort: Michael Phelps gewann insgesamt 28 Medaillen, davon 23 Gold.

Diese beiden Paare von Antworten und Antworten sind sehr ähnlich. Es hat sich das Muster und die Struktur des obigen angesehen, und es hat auf die gleiche Weise geantwortet, indem es den Ton und die Länge angepasst hat.

Aufforderung zu wenigen Schüssen

Die Eingabeaufforderung für wenige Schüsse erfolgt durch Angabe von mehr als einem Beispiel dafür, wie die KI reagieren soll.

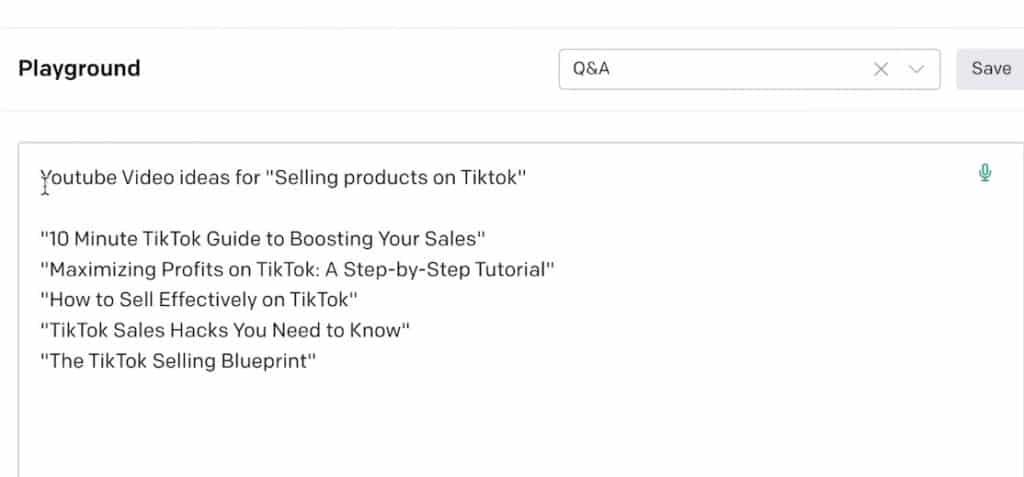

Hier habe ich eine kleine Aufforderung, die aus einem Ideengenerator für YouTube-Videos besteht.

Was ich getan habe, ist ein Frage-Antwort-Paar aufzustellen.

Die Frage – „YouTube-Videoideen für den Verkauf von Produkten auf TikTok“.

Dann habe ich 5 Beispiele gegeben, die ich gerade aus Chat GPT genommen und dort eingefügt habe.

???? Pro Tip: Diese Daten hier sind wirklich wichtig. Wenn Sie versuchen, Few Shot zu verwenden, um ein bestimmtes Ergebnis zu erzielen, sind die Dinge, die Sie als Beispiele eingeben, sehr wichtig.

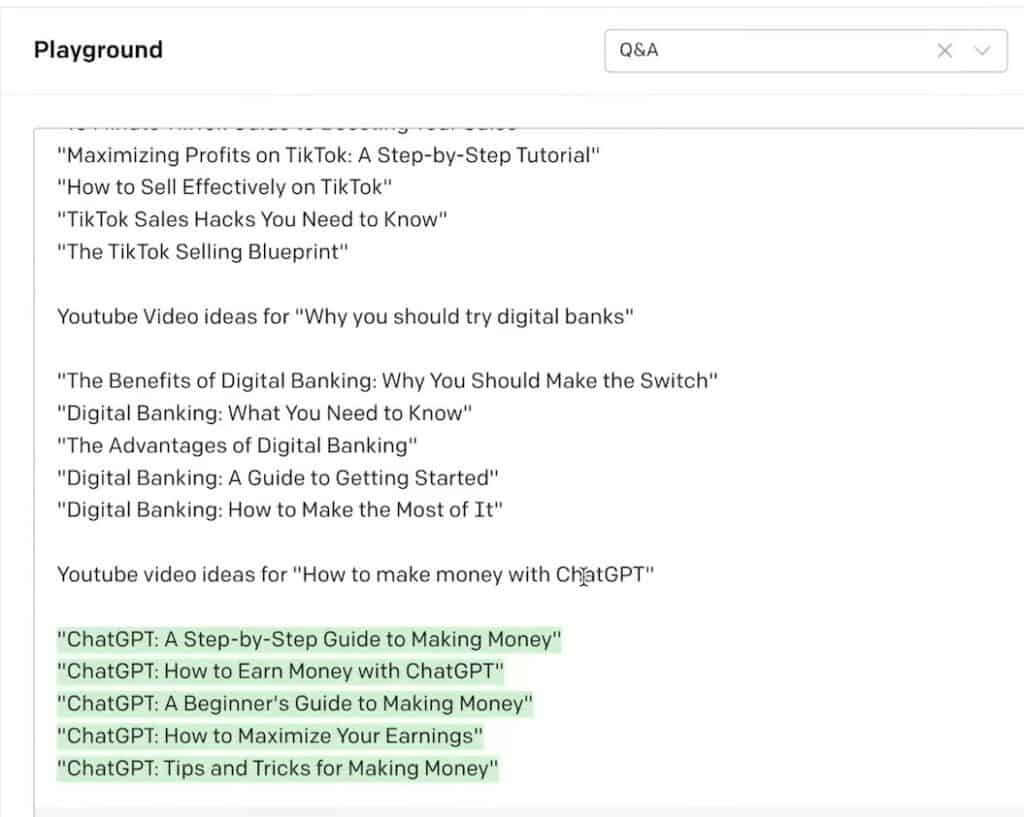

Wenn ich nun den Rest der Eingabeaufforderung hinzufüge, habe ich diesen nächsten Teil, der die zweite Aufnahme der Eingabeaufforderung mit wenigen Aufnahmen ist: „YouTube-Videoideen, warum Sie digitale Banken ausprobieren sollten“

Ich habe weitere 5 Beispiele gegeben und alles, was ich jetzt tun muss, ist eine weitere Frage einzufügen – „YouTube-Videoideen, wie man mit Chat GPT Geld verdient“.

Und die KI wird sich meine vorherigen Eingabeaufforderungen ansehen und mir dann eine Antwort geben, die auf der Struktur und dem Inhalt dieser vorherigen Eingabeaufforderungen basiert.

Und einfach so haben wir GPT-3 genommen und es in einen YouTube-Video-Ideengenerator verwandelt, der auf den Stilen, die ich mag, und den Titeln basiert, die hier mit der Methode der wenigen Aufnahmen bereitgestellt werden.

Indem Sie immer mehr Beispiele hinzufügen, können Sie die gewünschte Ausgabe genauer definieren.

Entscheidende Aspekte Ihrer Antwort, wie Tonfall, Länge und Struktur, können alle anhand der von Ihnen bereitgestellten Beispiele bestimmt werden.

Ein weiteres Beispiel wäre ein Q&A-Bot.

Wenn am Ende eine Frage gestellt wird, wirft die KI einen Blick auf die Rollenaufforderung oben, macht sich an die Rolle und sieht sich dann alle diese bereitgestellten Beispiele an und sagt: „Okay, das sind die Arten von Antworten, die von mir erwartet werden.“

So lang sind sie. Dies ist der Tonfall. Das ist die Struktur. So bringen Sie es bei, um die gewünschten Ergebnisse zu erzielen.

Wenn Sie zum Beispiel diese Antworten nehmen und sie erweitern und sie zu einem ganzen Absatz machen und das für jede einzelne Frage tun würden, dann wird Ihnen, wenn Sie eine Frage stellen, auch ein ganzer Absatz zurückgegeben.

Es ist wichtig zu verstehen, warum Shop-Eingabeaufforderung so gut funktioniert. Dies liegt daran, dass große Sprachmodelle im Wesentlichen nur Maschinen zur Mustererkennung und -generierung sind.

Kette von Gedankenanstößen

Ein weiteres nützliches Tool, das Sie in Ihrem Prompt-Engineering-Toolkit haben sollten, um den größtmöglichen Nutzen aus diesen Modellen zu ziehen, heißt Chain of Thought Prompting.

Die Aufforderung zur Gedankenkette ermutigt das große Sprachmodell, seine Argumentation zu erklären, während es die Schritte durchläuft, was normalerweise zu besseren und genaueren Ergebnissen führt.

Die Genauigkeitssteigerung macht sich besonders bemerkbar in:

- Rechenaufgaben

- Aufgaben des gesunden Menschenverstandes und

- Aufgaben zum symbolischen Denken

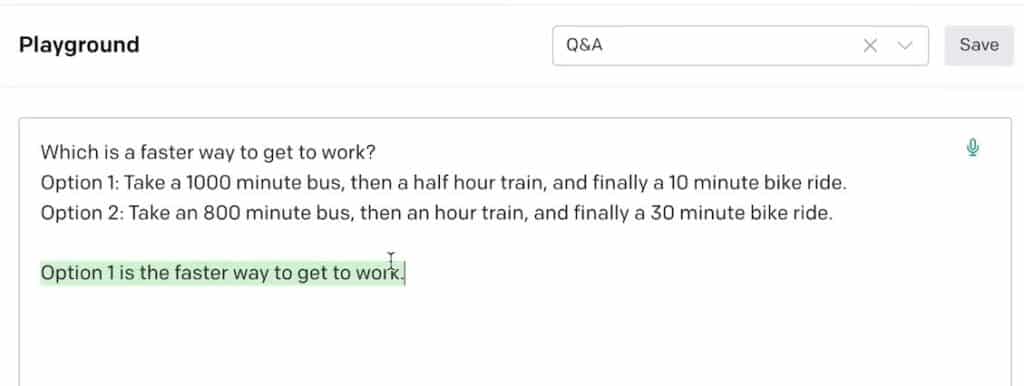

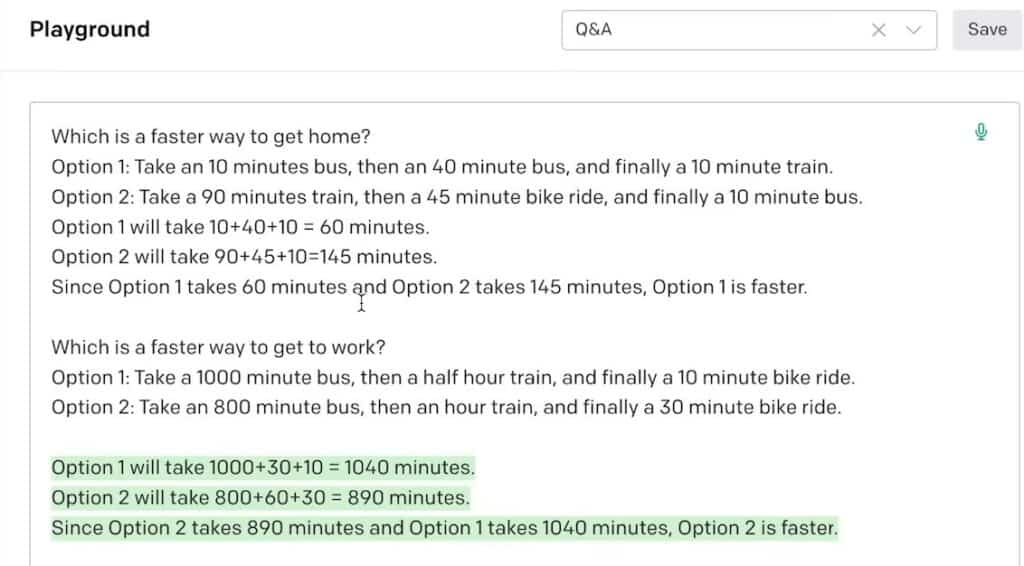

Hier haben wir eine Wortgleichung, die fragt, was der schnellere Weg zur Arbeit ist.

Die Antwort, die ich zurückbekomme, ist, dass Option 1 der schnellere Weg zur Arbeit ist.

Was wir feststellen, wenn wir die Eingabeaufforderung ändern, ist, dass dies tatsächlich die falsche Antwort war.

Wenn wir die Eingabeaufforderung ändern und sie dazu bringen, das Denken zu erklären, kommt tatsächlich eine andere Antwort heraus, nämlich Option 2.

Gedankenketten wie diese sind wirklich praktisch für diese speziellen Arten von Aufgaben. Es ist eine großartige Sache, die Sie als schneller Ingenieur in Ihrem Werkzeugkasten haben.

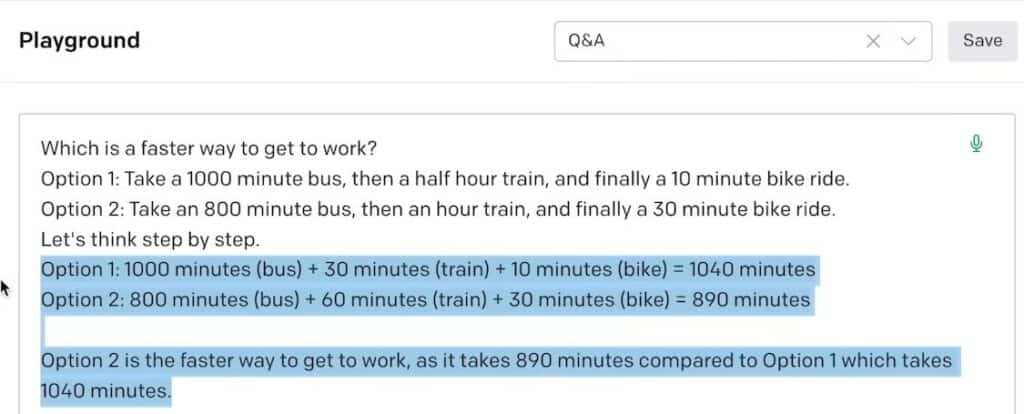

Eine andere Methode, um eine Gedankenkette zu erstellen, wird tatsächlich als Zero-Shot-Gedankenkette bezeichnet.

Wenn wir diesen magischen kleinen Satz hinzufügen „Denken wir Schritt für Schritt“ zu unserer Zero-Shot-Eingabeaufforderung erhalten wir eine etwas andere Antwort als zuvor.

Einfach so haben wir die richtige Antwort, nämlich Option 2, indem wir sie bitten, Schritt für Schritt für uns zu denken.

Sie denken vielleicht, was ist der Unterschied zwischen einem Einzelschuss und einer Zero-Shot-Gedankenantwort wie dieser?

Nun, in dieser Situation ist es sehr einfach, eine Eingabeaufforderung für einzelne oder wenige Aufnahmen zu erstellen, indem Sie sich ein paar Beispiele ausdenken und diese Frage ein wenig anpassen.

Wenn die Aufgabe weitaus komplexer ist, ist es manchmal nicht möglich, mehrere Beispiele oder sogar nur ein einziges Beispiel zur Verwendung in einer Aufnahmeaufforderung zu erhalten.

Daher dieses kleine Zauberwort von Denken wir Schritt für Schritt kann der Unterschied zwischen dem Extrahieren richtiger und falscher Antworten mit Ihren Eingabeaufforderungen sein.

Jetzt, da Sie die Grundlagen verstehen, können wir uns mit dem befassen, wofür Sie wirklich hier sind. Was sind die größten Chancen für schnelle Ingenieure im Jahr 2023 und darüber hinaus?

Was sind die größten Chancen für Prompt Engineers im Jahr 2023?

Experten mögen Dr. Alan D. Thompson haben gesagt, dass wir ein bis zwei Jahre Zeit haben, in denen Prompt Engineering äußerst wertvoll sein wird, aber bald durch künstliche Intelligenz ersetzt wird, die ihre eigenen Prompts schreiben kann.

Wie können wir also innerhalb dieser zwei Jahre das Beste aus dieser äußerst lukrativen Fähigkeit herausholen?

Verkaufen Sie Ihre Dienste als Prompt Engineer

Zunächst und am offensichtlichsten ist es, Ihre Dienste als prompter Ingenieur zu verkaufen. Die Nachfrage nach dieser Fähigkeit explodiert gerade. Geben Sie sich ein oder zwei Monate Zeit, um es zu lernen und ein Experte zu werden, und fangen Sie dann an, auszugehen und zu versuchen, Ihre eigenen Gigs zu finden.

Unternehmen auf der ganzen Welt stellen gerade dafür ein, also müssen Sie nur die Fähigkeit erlernen, rausgehen und an Türen klopfen.

Erstellen Sie ein Lehrunternehmen aus Prompt Engineering

Die zweite Möglichkeit, die ich sehe, besteht darin, aus Prompt Engineering ein Lehrunternehmen zu machen. Wir werden sehen, dass Unternehmen auf der ganzen Welt sich darauf konzentrieren müssen, diese Modelle zu verstehen und zu nutzen.

Eine der einfachsten Möglichkeiten für diese Unternehmen, sich diese stattfindende KI-Revolution zunutze zu machen und diese Tools einzusetzen, um die Produktivität ihres Unternehmens und ihrer Mitarbeiter zu steigern, besteht darin, ihnen den Umgang mit diesen Tools beizubringen.

Wenn Sie in diese Unternehmen gehen und ihnen Fähigkeiten wie schnelles Engineering beibringen und ihnen eine Reihe von Tools zur Verfügung stellen können, mit denen sie ihre Produktivität verbessern können, dann haben Sie einige wirklich gute Möglichkeiten, mit dem Verkauf an diese großen Unternehmen Geld zu verdienen Firmen.

Starten Sie ein KI-Unternehmen

Schließlich ist meine bevorzugte Art, mit Prompt Engineering Geld zu verdienen, der, Unternehmen um eine gut geschriebene Prompt herum aufzubauen.

Wir sehen extreme Werte, die mit nur einer gut geschriebenen Eingabeaufforderung freigeschaltet werden.

Ein großartiges Beispiel dafür ist Lita AI von Dr. Allen D. Thompson. Wenn Sie ihn noch nicht untersucht haben, schlage ich vor, dass Sie ihn überprüfen.

Aber was er getan hat, ist im Grunde genommen ein GPT-3-Modell, hat eine sehr spezifische Eingabeaufforderung geschrieben und mit dieser Eingabeaufforderung hat er im Grunde diesen KI-Assistenten namens Leta erstellt.

Indem er solch einen Qualitätsprompt schreibt, ist er in der Lage, eine KI zu erschaffen, die genau den richtigen Charakter hat, den er will.

Was er getan hat, ist eine Webcam eingerichtet und er hat von Angesicht zu Angesicht mit dieser KI gesprochen und sie mit der Welt geteilt.

Obwohl er es noch zu Geld gemacht hat und es eher ein Forschungsprojekt ist, ist es verrückt zu sehen, was nur ein paar Sätze gut geschriebenen Textes bewirken können, um diese so mächtigen Sprachmodelle in diese völlig neuen und mächtigen Dinge für sich zu verwandeln.

Dies ist ein Beispiel dafür, wie Sie Eingabeaufforderungen verwenden und verschiedene Datenbits und Benutzereingaben abrufen können, um ein kleines Tool zu erstellen. Wenn Sie dies nehmen und es auf einer Website veröffentlichen und ein wenig Marketing betreiben, bin ich sicher, dass Sie mit einem dieser sehr einfachen Tools etwas Geld verdienen können.

Ich denke ernsthaft, dass ein solches promptes Engineering zur Änderung dieser Modelle eine noch niedrigere Eintrittsbarriere für Leute darstellt, die Unternehmen mit KI aufbauen möchten. Alles, was es braucht, ist eine sorgfältig geschriebene Eingabeaufforderung und vielleicht ein bisschen Benutzereingabe, die aufeinander abgestimmt ist, und Sie können in etwa einer halben Stunde ein wertvolles Geschäft aufbauen.

Prompt Engineering Schlussworte

Jetzt kennen Sie die Grundlagen des Prompt Engineering.

Sie können rausgehen und anfangen, es mehr zu üben, anfangen, Ihre Dienstleistungen zu verkaufen, anfangen, Menschen zu unterrichten oder Unternehmen aufzubauen, die auf Aufforderungen zum Schreiben basieren.

Patryk Miszczak