Statistiques GPT-3 2023 : utilisation, paramètres, cas d'utilisation, etc.

GPT-3, une initiative OpenAI, est la troisième variante de la série GPT-n et est considérée comme le modèle de langage le plus puissant à ce jour.

Cette nouvelle technologie d'IA peut être utilisée pour une variété de tâches et elle est maintenant accessible au public.

Nous avons recherché et compilé les dernières statistiques GPT-3. Vous découvrirez comment cette nouvelle technologie change le paysage de l'intelligence artificielle.

- , AI

Principales statistiques GPT-3

Certaines des statistiques intéressantes de GPT-3 sont indiquées ci-dessous :

- GPT-3 est bien en avance sur les modèles existants avec des paramètres entraînables 175B [1].

- GPT-3 possède les plus grandes données de formation, un énorme 45 To [2].

- GPT-3 est utilisé par plus de 300 applications [3].

- En mars 2021, une moyenne de 4.5 milliards de mots sont générés par jour [3].

- Algolia a testé GPT-3 sur 2.1 millions d'articles de presse et obtient une précision de 91 % [3].

- GPT-3 est 117 fois plus complexe que GPT-2 [10].

Modèles et paramètres GPT-3

Divers Traitement du langage naturel des modèles sont disponibles et en constante évolution. Les principales statistiques de classement GPT-3 en termes de différents modèles sont les suivantes :

- Les ressources de formation du modèle d'apprentissage en profondeur ont doublé tous les 3.4 mois au cours de la dernière décennie [4].

- Une augmentation de 300K fois des ressources de calcul est observée entre 2012 et 2018 [4].

- Actuellement, GPT-3 possède le plus grand corpus de données de 45 To formé avec 499 milliards de jetons [2].

- Un modèle précédent T5 a été formé sur seulement un ensemble de données de 7 To [6].

- GPT-3 a 175B paramètres entraînables [1].

- La technologie perturbatrice de GPT-3 montre qu'environ 70 % du développement de logiciels peut être automatisé [7].

- Les modèles NLP antérieurs, ELMo, avaient 94M de paramètres, BERT en avait 340M, GPT-2 en avait 1.5B et Turing NLG en avait 17B [8].

- BERT de Google a 470 fois moins de paramètres que GPT-3 [9].

- GPT-3 contient 100 fois plus de paramètres que son prédécesseur GPT-2 [1].

- GPT-3 a 10 fois plus de paramètres que le modèle Turing NLG de Microsoft [1].

- La capacité des modèles GPT-n est augmentée de 3 ordres de grandeur avec GPT-3.

- GPT-3 est 117 fois plus complexe que GPT-2 [10].

- GPT-3 a surpassé SOTA pour l'ensemble de données LAMBDA avec une amélioration de l'efficacité de 8 % [2].

- Comparé à SOTA qui fournit une précision de 60% pour l'addition et la soustraction à deux chiffres, le modèle GPT-3 Fine-tuned représente 100% [11].

- Algolia basé sur GPT-3 répond avec précision à des questions complexes en langage naturel 4 fois mieux que BERT [3].

- En novembre 2021, Microsoft a annoncé un modèle plus grand Megatron-Turing NLG avec des paramètres 530B [8].

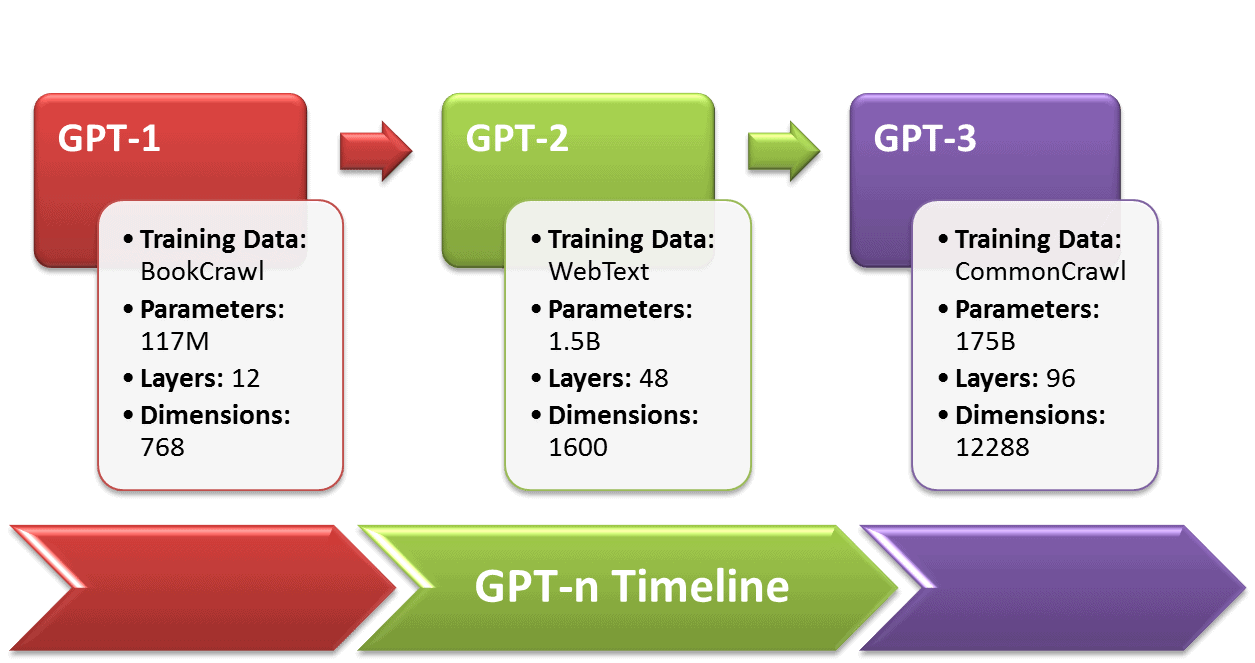

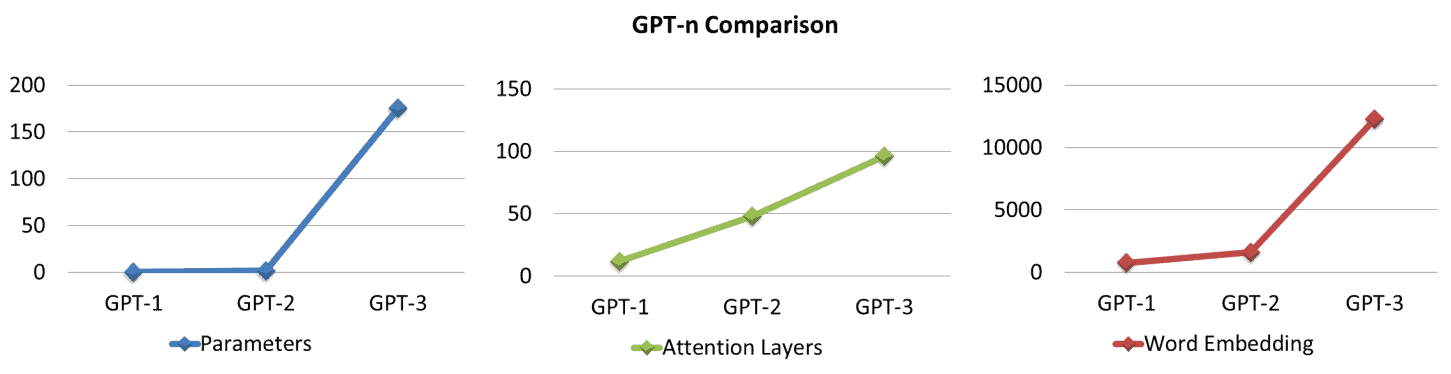

Chronologie GPT-n

En 2018, la série GPT-n a été lancée par OpenAI pour améliorer les modèles NLP, c'est-à-dire la parole, le texte et le codage de type humain. Une comparaison statistique de GPT-n est fournie ci-dessous : [1]

- GPT-1 a 12 couches avec 12 têtes d'attention et un état à 768 dimensions.

- Les données de formation de GPT-1, BooksCorpus, contenaient près de 7000 5 livres non publiés représentant environ XNUMX Go de texte.

- Le GPT-1 s'est bien comporté dans 9 tâches sur 12 par rapport aux modèles SOTA supervisés, ainsi que des performances de tir zéro décentes sur diverses tâches.

- GPT-2, un successeur de GPT-1 lancé en 2019, est formé sur 10 fois plus de paramètres et de quantité de données que GPT-1.

- GPT-2 a des paramètres 1.5B et un ensemble de données 40GB, WebText, y compris des pages Web 8M.

- GPT-2 a fourni des résultats améliorés pour 7 des 8 modèles SOTA existants et a également bien fonctionné dans le cadre du zéro coup.

- GPT-3 surpasse les modèles de langage antérieurs avec des paramètres 100x par rapport à GPT-2.

- GPT-3 a 175 B de paramètres pouvant être entraînés et une intégration de 12288 XNUMX mots (dimensions).

|

Modèle |

Lancement Année |

Données d'entraînement |

Paramètres de formation |

Couches d'attention |

Incorporation de mots |

Têtes d'attention |

|

GPT-1 |

2018 |

7000 livres ~ 5 Go |

117M |

12 |

768 |

12 |

|

GPT-2 |

2019 |

8 millions de documents ~ 40 Go |

1.5M |

48 |

1600 |

48 |

|

GPT-3 |

2020 |

Source multiple ~ 45 To |

175M |

96 |

12288 |

96 |

Statistiques du modèle de formation GPT-3

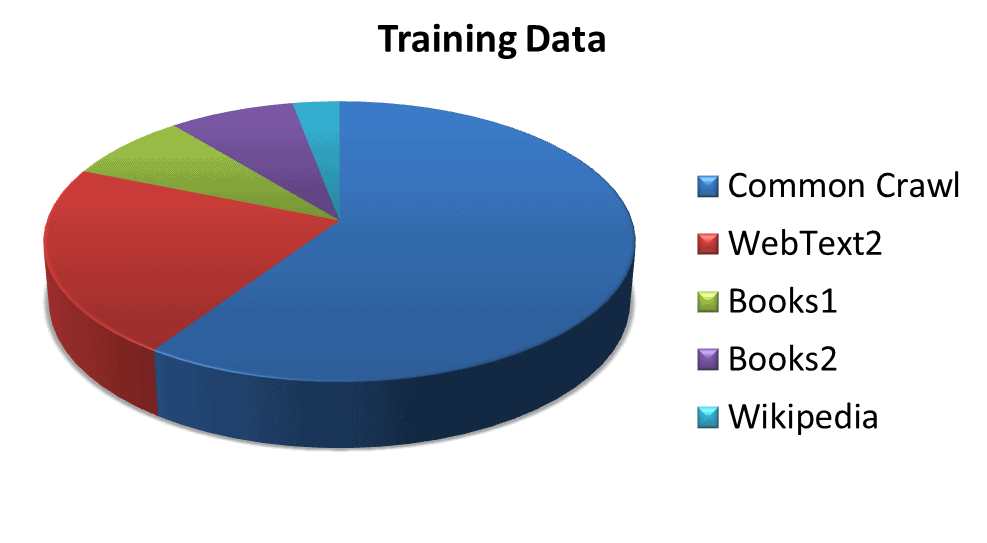

Les statistiques de plusieurs ensembles de données utilisés pour entraîner le modèle sont les suivantes :

- GPT-3 est entraîné avec un total de 499 B jetons, soit 700 Go [2].

- Exploration commune pondéré à 60 %, contient diverses données issues de l'exploration du Web au fil des ans [2].

- TexteWeb2 couvrant 22 %, inclut l'ensemble de données des liens Reddit sortants [2].

- Livres1 et Livres2 avec une part combinée de 16 %, contiennent des corpus de livres sur Internet [2].

- Wikipédia pondéré 3%, comprend des données de pages Wikipédia en anglais [2].

|

Ensemble de données |

Tokens |

Pondération des ensembles de données dans la formation |

|

Common Crawl (filtré) |

410 milliards |

60% |

|

TexteWeb2 |

19 milliards |

22% |

|

Livres1 |

12 milliards |

8% |

|

Livres2 |

55 milliards |

8% |

|

Wikipédia |

3 milliards |

3% |

Source: (https://arxiv.org/pdf/2005.14165.pdf)

Statistiques du modèle d'entreprise GPT-3

GPT-3 n'est pas disponible en open source mais via une API commerciale. Certaines des statistiques étonnantes concernant le statut de l'entreprise et le coût de fonctionnement de GPT-3 sont les suivantes :

- En 2015, OpenAI a commencé comme un laboratoire de recherche à but non lucratif.

- En 2019, OpenAI est passée d'une organisation à but non lucratif à une entreprise à but lucratif [5].

- Microsoft s'est associé à OpenAI avec un investissement de 1 milliard de dollars [12].

- La formation GPT-3 nécessite 3.114 × 1023 FLOPS (opérations en virgule flottante) qui coûtent 4.6 millions de dollars en utilisant une instance cloud Tesla V100 à 1.5 $/heure et prennent 355 années-GPU [13].

- GPT-3 ne peut pas être formé sur un seul GPU, mais nécessite un système distribué qui augmente le coût de formation du modèle final de 1.5x à 5x [14].

- Le coût de R&D de GPT-3 varie de 11.5 M$ à 27.6 M$, hors frais généraux des GPU parallèles, des salaires et des coûts des sous-modèles [14].

- En parallèle, GPT-3 nécessite au moins 11 GPU Tesla V100 avec 32 Go de mémoire chacun, pour un coût de 9,000 99,000 $/pièce totalisant 13 XNUMX $ pour le cluster GPU hors RAM, CPU, disques SSD et alimentation [XNUMX].

- Le modèle GPT-3 coûte 12.6 millions de dollars avec au moins 350 Go de VRAM (FLOP demi-précision à 16 bits/paramètre) juste pour charger le modèle et exécuter l'inférence, plaçant la VRAM au nord de 400 Go [15].

- Les coûts matériels de fonctionnement seraient de 100,000 150,000 $ à 14 XNUMX $ en négligeant les coûts d'alimentation, de refroidissement et de sauvegarde [XNUMX].

- Un serveur DGX-1 de base de Nvidia, VRAM (8 × 16 Go), coûte environ 130,000 3 $, y compris tous les autres composants, pour une performance solide sur GPT-16 [XNUMX].

- S'il est exécuté dans le cloud, GPT-3 nécessite au moins le p3dn.24xlarge d'Amazon, avec 8xTesla V100 (32 Go), 768 Go de RAM et 96 cœurs de processeur, et coûte 10 à 30 $/heure, et un minimum de 87,000 14 $ par an [XNUMX]. .

- OpenAI peut travailler en collaboration avec Microsoft sur du matériel spécialisé, tel que le supercalculateur menant à des solutions rentables [14].

- GPT-3 dispose d'un supercalculateur hébergé dans le cloud Azure de Microsoft, composé de 285 10 cœurs de processeur et de 17 XNUMX GPU haut de gamme [XNUMX].

- Le plan de tarification préliminaire fournit à OpenAI une marge bénéficiaire de près de 6,000 18 %, ce qui permet de nombreux ajustements si le plan d'affaires actuel n'apporte pas de clients [XNUMX].

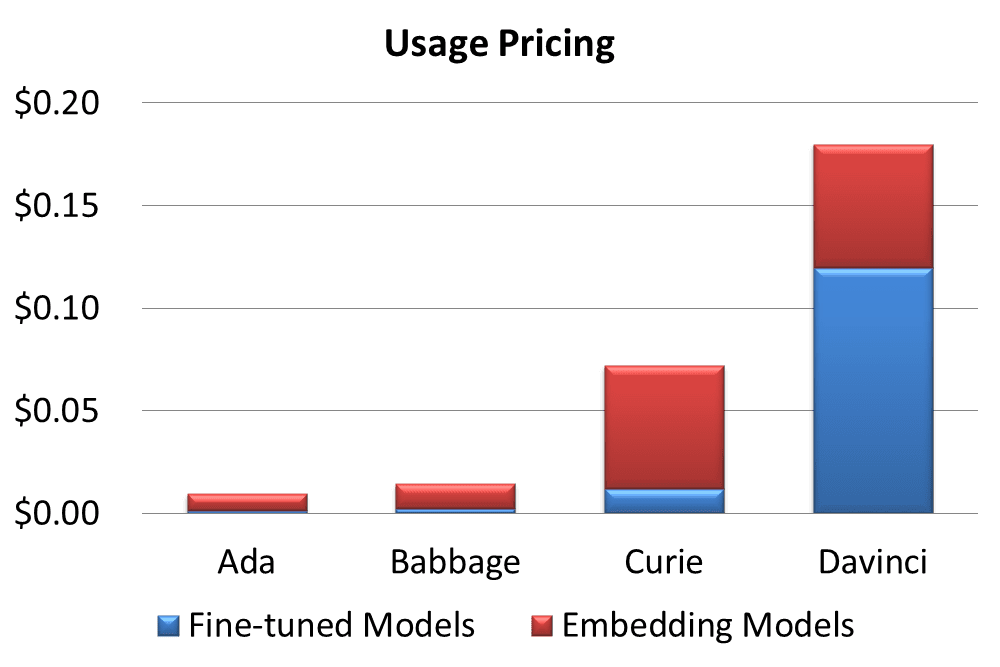

Tarification GPT-3

OpenAI propose divers plans tarifaires pour son API. Certaines des statistiques de prix sont définies ici,

- GPT-3 a un plan gratuit, Start for free, pour 18 $ de crédit gratuit pendant les 3 premiers mois [19].

- Deux autres forfaits payants incluent un « Pay as you go » flexible et un complexe « Choisissez votre modèle » [19].

- La facturation se fait par 1000 jetons soit environ 750 mots [19]

- Un jeton équivaut à 4 caractères ou 0.75 mots pour un texte anglais [19].

- Chaque modèle a une longueur de contexte maximale prédéfinie, allant de 1500 à 2048 jetons [20].

- Sur la base de l'éventail des capacités et des choix, GPT-3 propose 4 modèles de tarification [21].

- Ada, au prix de 0.0008 $/1 21 jetons, est le plus rapide au prix de capacités moindres [XNUMX].

- Babbage coûte 0.0012 $/1 21 jetons, est bon pour les tâches simples [XNUMX].

- Curie a facturé des jetons de 0.0060 $ / 1K, a la capacité d'effectuer des tâches nuancées et est bon comme chatbot général [21].

- Davinci au prix de 0.0600 $/1 21 tokens donne les meilleurs résultats pour les intentions complexes [XNUMX].

- GPT-3 fournit un modèle Fine-tuned personnalisable facturé à 50 % du prix de base et un modèle Embedding coûteux pour construire une recherche avancée [22,23].

|

Modèle |

Dimensions |

Tarification / Jetons 1K |

Formation / Jetons 1K |

Utilisation |

Utilisation |

|

Ada |

1024 |

$0.0008 |

$0.0004 |

$0.0016 |

$0.0080 |

|

Babbage |

2048 |

$0.0012 |

$0.0006 |

$0.0024 |

$0.0120 |

|

Curie |

4096 |

$0.0060 |

$0.0030 |

$0.0120 |

$0.0600 |

|

Da Vinci |

12288 |

$0.0600 |

$0.0300 |

$0.1200 |

$0.0600 |

Source: (https://openai.com/api/pricing/)

La commercialisation de GPT-3 conduit plusieurs plateformes utilisatrices de services à passer en mode payant :

- PhilosopherAI a déclaré un coût de service d'au moins 4,000 24 $/mois [XNUMX].

- AI Dungeon a introduit un modèle Dragon premium pour la version basée sur GPT-3 facturant 10 $ par mois [25].

Statistiques du modèle personnalisé GPT-3

Les clients adaptent les modèles GPT-3 à leurs besoins et obtiennent des résultats époustouflants. Voici quelques statistiques :

- Le réglage fin améliore la précision par rapport à l'ensemble de données des problèmes de mathématiques de l'école primaire de 2 à 4 fois [26].

- Les sorties correctes d'un client sont augmentées de 83% à 95% [26].

- Le taux d'erreur d'un autre client est réduit de 50 % avec un modèle sur mesure [26].

- La fréquence des sorties non fiables est réduite de 17% à 5% pour un client [26].

- Les avantages du réglage fin du GPT-3 commencent à apparaître dans moins de 100 exemples [26].

Les statistiques des applications alimentées par GPT-3 personnalisé présentent des résultats prometteurs :

- Les performances de Keeper Tax augmentent de 85 % à 93 %, avec 500 nouveaux exemples de formation une fois par semaine [27].

- Les rapports viables ont amélioré la précision de 66 % à 90 % en résumant les commentaires des clients [28].

- La génération de questions et de contenu de Sana Lab a permis une amélioration de 60 % des réponses générales grammaticalement correctes à des réponses très précises [2].

- Elicit observe une amélioration de 24 % de la compréhensibilité des résultats, de 17 % de la précision et de 33 % globalement [26].

Architecture du modèle GPT-3

Le modèle basé sur le transformateur a une architecture massive divisée en sous-modèles.

- GPT-3 a 8 modèles basés sur des tailles de paramètres allant de 125M à 175B [2].

- L'architecture basée sur l'attention a des couches d'attention allant de 12 dans le plus petit modèle à 96 dans le plus grand [2].

- Les couches de transformateur vont de 12 à 96 [2].

- Le taux d'apprentissage passe de 6.0 × 10-4 à 0.6 × 10-4 [2].

|

Modèle |

Paramètres pouvant être entraînés |

Couches de transformateur |

Unités de couche de goulot d'étranglement |

Couches d'attention |

Dimension de la tête d'attention |

Taille du lot |

Taux d'apprentissage |

|

GRT-3 petit |

125M |

12 |

768 |

12 |

64 |

0.5M |

6.0 × 10-4 |

|

Moyen GRT-3 |

350M |

24 |

1024 |

24 |

64 |

0.5M |

3.0 × 10-4 |

|

GRT-3 Grand |

760M |

24 |

1536 |

24 |

96 |

0.5M |

2.5 × 10-4 |

|

GRT-3XL |

1.3M |

24 |

2048 |

24 |

128 |

1M |

2.0 × 10-4 |

|

GRT-3 2.7B |

2.7M |

32 |

2560 |

32 |

80 |

1M |

1.6 × 10-4 |

|

GRT-3 6.7B |

6.7M |

32 |

4096 |

32 |

128 |

2M |

1.2 × 10-4 |

|

GRT-3 13B |

13.0M |

40 |

5140 |

40 |

128 |

2M |

1.0 × 10-4 |

|

GRT-3 175B |

175.0M |

96 |

12288 |

96 |

128 |

2M |

0.6 × 10-4 |

La source: https://arxiv.org/pdf/2005.14165.pdf

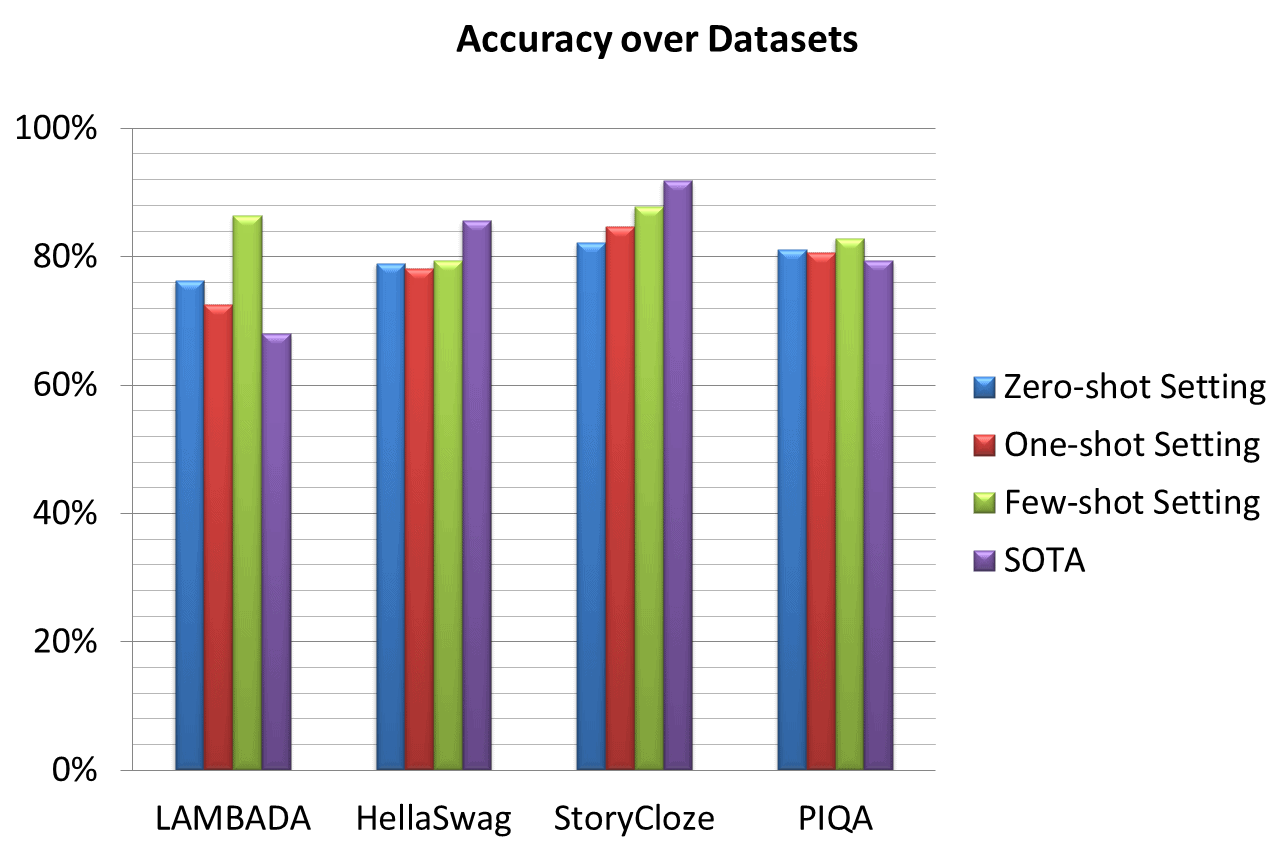

Performances et précision du GPT-3

Les performances et la précision de GPT-3 sont étudiées sur divers ensembles de données existants. Les statistiques de performances intéressantes sont les suivantes :

- Une amélioration significative des performances est décrite par rapport à LAMBADA et PhysicalQA (PIQA) [2].

- Un gain important de 8 % est obtenu dans le réglage LAMBADA à tir zéro par GPT-3 par rapport à SOTA [2].

- Une amélioration substantielle de la précision de 4 % est décrite pour PIQA par rapport au SOTA précédent - un RoBERTa affiné [2].

- HellaSwag et StoryCloze ont montré des performances respectables mais toujours inférieures à SOTA [2].

- Les résultats de HellaSwag sont inférieurs à ceux du modèle multitâche ALUM [29].

- StoryCloze est 4.1% derrière le SOTA en utilisant le modèle BERT affiné [29].

- Winograd affiche respectivement 88.3 %, 89.7 % et 88.6 % dans les paramètres zéro coup, un coup et quelques coups, et affiche des résultats solides mais inférieurs à SOTA [13].

- Le modèle affiné GPT-3 représente une précision de 100 % pour l'addition et la soustraction à deux chiffres [11].

- Les articles courts (~ 200 mots) écrits par GPT-3 175B sont humainement détectables pour le changement à ~ 52% [13].

- Les articles écrits par GPT-3 125M sont à 76% détectables par l'homme. ([13])

|

Ensemble de données |

Réglage zéro coup |

Réglage unique |

Réglage peu de coups |

SOTA |

|

LAMBADA |

76.2% |

72.5% |

86.4% |

68% |

|

HellaSwag |

78.9% |

78.1% |

79.3% |

85.6% |

|

HistoireClose |

82.2% |

84.7% |

87.7% |

91.8% |

|

AQ physique (PIQA) |

81.0% |

80.5% |

82.8% |

79.4% |

La source: https://www.springboard.com/blog/data-science/machine-learning-gpt-3-open-ai/

Plates-formes alimentées par GPT-3

Certaines des entreprises et des applications utilisant GPT-3 sont mentionnées dans les statistiques de modèles sur mesure et les statistiques de tarification. Les statistiques de certaines autres plates-formes et applications alimentées par GPT-3 sont indiquées ci-dessous :

- GPT-3 est utilisé par plus de 300 applications [30]

- La plate-forme compte des dizaines de milliers de développeurs dans le monde [11].

- En mars 2021, une moyenne de 4.5 milliards de mots sont générés par jour [30].

- Algolia a testé GPT-3 sur 2.1 millions d'articles de presse et obtient une précision de 91 % [30].

- Duolingo utilisant GPT-3 a observé une amélioration de 12 % de la précision des prédictions et de l'engagement des utilisateurs [31].

- DALL·E 2 basé sur 12B GPT-3 est préféré par 71.7 % des utilisateurs pour la correspondance des légendes et par 88.8 % pour le réalisme photo [32].

Cas d'utilisation de GPT-3

GPT-3 est un nouveau système d'intelligence artificielle qui serait le système d'IA le plus puissant au monde. GPT-3 a de nombreuses utilisations potentielles, notamment aider les humains dans leur travail, fournir un meilleur service client et même devenir un assistant personnel. Voici quelques-uns des cas d'utilisation courants de GPT-3 :

La Brochure

GPT-3, le plus grand modèle d'intelligence artificielle au monde, est désormais accessible au public. Et les entreprises s'en rendent compte. Les entreprises utilisent déjà l'IA pour améliorer le service client, créer de nouveaux produits et automatiser les tâches répétitives.

Marketing

GPT-3 est un puissant outil de marketing. Outils marketing IA peut vous aider à créer un meilleur contenu, à cibler votre public plus efficacement et à suivre vos résultats. De plus, GPT-3 peut vous aider à suivre vos progrès et à analyser vos résultats afin que vous puissiez optimiser vos stratégies marketing.

Service à la clientèle

L'IA dans le service client révolutionne la façon dont les entreprises interagissent avec leurs clients. En automatisant les tâches de routine et en fournissant des réponses instantanées aux questions courantes, l'IA aide les entreprises à améliorer leur expérience de service client. De plus, les chatbots alimentés par GPT-3 peuvent gérer les demandes complexes des clients, libérant ainsi des agents humains pour fournir un service plus personnalisé.

L'analyse des données

L'IA peut aider à identifier des modèles et des corrélations que les humains pourraient manquer. Il peut également aider à automatiser le processus d'analyse, le rendant plus rapide et plus facile. De plus, l'IA peut fournir des informations qui ne seraient pas possibles sans son aide. Pour ces raisons, l'IA devient un outil essentiel pour les analystes de données.

Création de contenu

Basé sur GPT-3 Outils de création de contenu IA sont utilisés pour écrire des articles, créer des vidéos et même générer des publications sur les réseaux sociaux.

Conception

Outils de conception IA propulsé par GPT-3 ont le potentiel d'améliorer l'efficacité et la qualité du processus de conception en automatisant les tâches répétitives, en fournissant des recommandations personnalisées et en aidant à l'exploration des options de conception.

Mots finaux des statistiques GPT-3

L'article fournit l'histoire de la croissance du GPT-3 basée sur des statistiques importantes. Les modèles GPT-n se développent considérablement et la communauté des chercheurs s'intéresse au GPT-4. Selon un critique de Hacker News,

« Un cerveau humain typique possède plus de 100 3 milliards de synapses, soit trois autres ordres de grandeur de plus que le modèle GPT-175 1.5B. Étant donné qu'il faut à OpenAI à peu près un an et quart pour augmenter la capacité de leur modèle GPT de deux ordres de grandeur de 175 milliard à XNUMX milliard, avoir des modèles avec des billions de poids semble soudainement prometteur.

Bibliographie

- https://medium.com/walmartglobaltech/the-journey-of-open-ai-gpt-models-32d95b7b7fb2

- https://arxiv.org/pdf/2005.14165.pdf

- https://openai.com/blog/gpt-3-apps/

- https://towardsdatascience.com/gpt-3-a-complete-overview-190232eb25fd

- (https://futurism.com/ai-elon-musk-openai-profit)

- https://www.toptal.com/deep-learning/exploring-pre-trained-models

- https://www.gartner.com/en/documents/3994660

- (https://www.i-programmer.info/news/105-artificial-intelligence/14987-the-third-age-of-ai-megatron-turing-nlg.html)

- (https://360digitmg.com/gpt-vs-bert

- https://www.datacamp.com/blog/gpt-3-and-the-next-generation-of-ai-powered-services

- (https://singularityhub.com/2021/04/04/openais-gpt-3-algorithm-is-now-producing-billions-of-words-a-day/)

- (https://www.theverge.com/2019/7/22/20703578/microsoft-openai-investment-partnership-1-billion-azure-artificial-general-intelligence-agi)

- https://lambdalabs.com/blog/demystifying-gpt-3/

- https://bdtechtalks.com/2020/09/21/gpt-3-economy-business-model/

- https://cloudxlab.com/blog/what-is-gpt3-and-will-it-take-over-the-world/

- https://medium.com/@messisahil7/gpt-3-a-new-step-towards-general-artificial-intelligence-66879e1c4a44

- https://www.endila.com/post/is-gpt-3-really-the-future-of-nlp

- https://pakodas.substack.com/p/estimating-gpt3-api-cost?s=r

- https://openai.com/api/pricing/

- https://beta.openai.com/docs/introduction/key-concepts

- https://beta.openai.com/docs/models

- https://beta.openai.com/docs/guides/fine-tuning,

- https://beta.openai.com/docs/guides/embeddings/what-are-embeddings

- https://philosopherai.com/

- (https://aidungeon.medium.com/ai-dungeon-dragon-model-upgrade-7e8ea579abfe

- https://openai.com/blog/customized-gpt-3/

- ((https://www.keepertax.com/

- https://www.askviable.com/

- https://www.springboard.com/blog/data-science/machine-learning-gpt-3-open-ai/

- https://openai.com/blog/gpt-3-apps

- https://www.wired.com/brandlab/2018/12/ai-helps-duolingo-personalize-language-learning/

- https://openai.com/dall-e-2/

Patryk Miszczak