Estatísticas GPT-3 2023: uso, parâmetros, casos de uso e mais

O GPT-3, uma iniciativa OpenAI, é a terceira variante da linha da série GPT-n e é considerado o modelo de linguagem mais poderoso até hoje.

Essa nova tecnologia de IA pode ser usada para uma variedade de tarefas e agora está disponível ao público.

Pesquisamos e compilamos as últimas estatísticas do GPT-3. Você descobrirá como essa nova tecnologia está mudando o cenário da inteligência artificial.

- , AI

Principais estatísticas da GPT-3

Algumas das estatísticas interessantes do GPT-3 são indicadas abaixo:

- O GPT-3 está muito à frente dos modelos existentes com parâmetros treináveis 175B [1].

- O GPT-3 possui os maiores dados de treinamento, 45 TB [2].

- O GPT-3 está sendo usado por mais de 300 aplicativos [3].

- Em março de 2021, uma média de 4.5 bilhões de palavras são geradas por dia [3].

- Algolia testou o GPT-3 em 2.1 milhões de artigos de notícias e obteve 91% de precisão [3].

- GPT-3 é 117x mais complexo que GPT-2 [10].

Modelos e Parâmetros GPT-3

Vários Processamento de linguagem natural modelos estão disponíveis e continuam evoluindo. As estatísticas de classificação proeminentes do GPT-3 em termos de vários modelos são as seguintes:

- Os recursos de treinamento do modelo de aprendizado profundo dobraram a cada 3.4 meses durante a última década [4].

- Um aumento de 300 mil vezes nos recursos computacionais é observado entre 2012 e 2018 [4].

- Atualmente, o GPT-3 possui o maior corpus de dados 45TB treinado com 499 bilhões de tokens [2].

- Um modelo anterior T5 foi treinado em apenas um conjunto de dados de 7 TB [6].

- O GPT-3 possui parâmetros treináveis 175B [1].

- A tecnologia disruptiva do GPT-3 mostra que ~70% do desenvolvimento de software pode ser automatizado [7].

- Modelos anteriores de NLP, ELMo, tinham 94M de parâmetros, BERT tinha 340M, GPT-2 tinha 1.5B e Turing NLG tinha 17B [8].

- O BERT do Google tem 470x menos parâmetros que o GPT-3 [9].

- GPT-3 contém 100x mais parâmetros que seu predecessor GPT-2 [1].

- O GPT-3 tem 10x mais parâmetros do que o modelo Turing NLG da Microsoft [1].

- A capacidade dos modelos GPT-n é aumentada em 3 ordens de grandeza com GPT-3.

- GPT-3 é 117x mais complexo que GPT-2 [10].

- O GPT-3 superou o SOTA para o conjunto de dados LAMBDA com uma melhoria de 8% na eficiência [2].

- Comparado ao SOTA, que fornece 60% de precisão para adição e subtração de dois dígitos, o modelo GPT-3 com ajuste fino representa 100% [11].

- Algolia baseado em GPT-3 responde com precisão a questões complexas de linguagem natural 4x melhor do que BERT [3].

- Em novembro de 2021, a Microsoft anunciou um modelo maior Megatron-Turing NLG com parâmetros 530B [8].

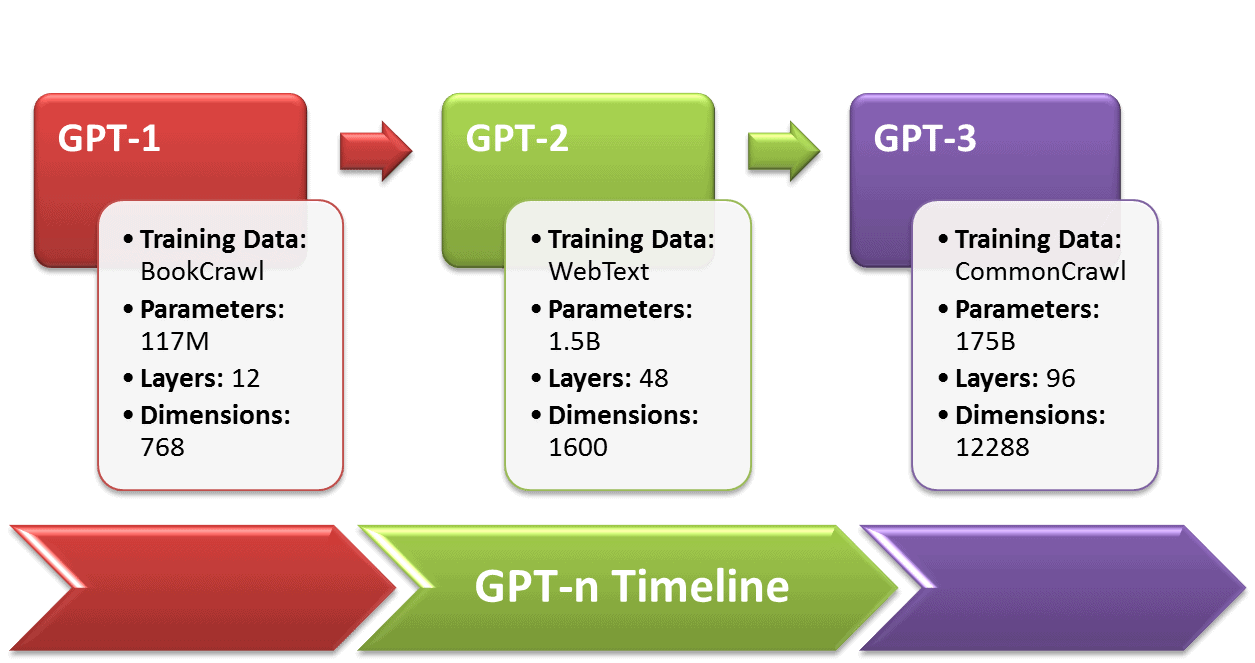

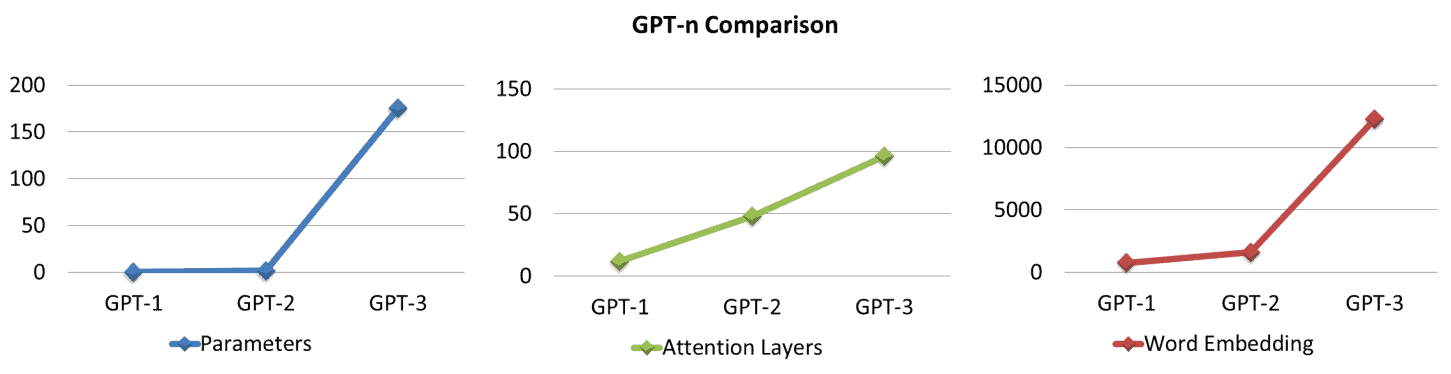

Linha do tempo GPT-n

Em 2018, a série GPT-n foi iniciada pela OpenAI para aprimorar os modelos de PNL, ou seja, fala, texto e codificação semelhantes a humanos. Uma comparação estatística de GPT-n é fornecida abaixo: [1]

- O GPT-1 possui 12 camadas com 12 cabeças de atenção e um estado de 768 dimensões.

- Os dados de treinamento do GPT-1, BooksCorpus, tinham quase 7000 livros não publicados, totalizando ~ 5 GB de texto.

- O GPT-1 teve um bom desempenho em 9 das 12 tarefas em comparação com os modelos SOTA supervisionados, juntamente com um desempenho de tiro zero decente em várias tarefas.

- O GPT-2, um sucessor do GPT-1 lançado em 2019, é treinado em 10x os parâmetros e a quantidade de dados do GPT-1.

- O GPT-2 possui parâmetros de 1.5B e conjunto de dados de 40GB, WebText, incluindo páginas da web de 8M.

- O GPT-2 forneceu resultados aprimorados para 7 dos 8 modelos SOTA existentes e também teve um bom desempenho na configuração de tiro zero.

- O GPT-3 supera os modelos de linguagem anteriores com parâmetros 100x maiores do que o GPT-2.

- O GPT-3 possui parâmetros treináveis de 175B e incorporação de 12288 palavras (dimensões).

|

Modelo |

Ano de lançamento |

Dados de treinamento |

Parâmetros de treinamento |

Camadas de Atenção |

Incorporação de palavras |

Chefes de atenção |

|

GPT-1 |

2018 |

7000 livros ~ 5 GB |

117M |

12 |

768 |

12 |

|

GPT-2 |

2019 |

8 milhões de documentos ~ 40 GB |

1.5B |

48 |

1600 |

48 |

|

GPT-3 |

2020 |

Fonte múltipla ~ 45 TB |

175B |

96 |

12288 |

96 |

Estatísticas do modelo de treinamento GPT-3

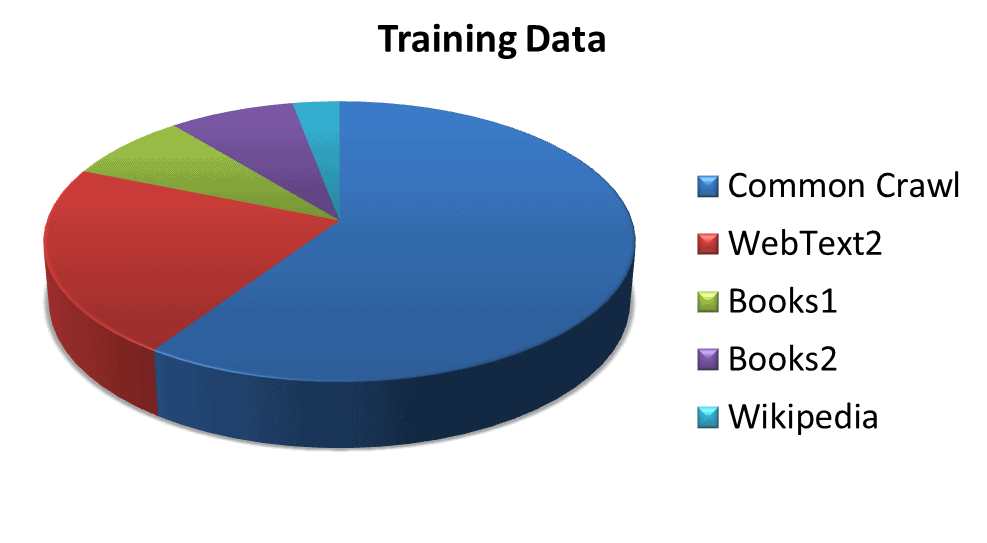

As estatísticas de vários conjuntos de dados usados para treinar o modelo são as seguintes:

- O GPT-3 é treinado com um total de 499B tokens, ou 700GB [2].

- Rastreio comum ponderado 60%, contém diversos dados de web crawling ao longo dos anos [2].

- WebText2 abrangendo 22%, inclui o conjunto de dados de links de saída do Reddit [2].

- Livros1 e Livros2 com uma quota combinada de 16%, contêm corpora de livros baseados na Internet [2].

- Wikipedia ponderado 3%, inclui dados das páginas da Wikipedia em inglês [2].

|

Conjunto de dados |

Tokens |

Peso do conjunto de dados no treinamento |

|

Rastreamento comum (filtrado) |

410 bilhões |

60% |

|

WebText2 |

19 bilhões |

22% |

|

Livros1 |

12 bilhões |

8% |

|

Livros2 |

55 bilhões |

8% |

|

Wikipedia |

3 bilhões |

3% |

Fonte: (https://arxiv.org/pdf/2005.14165.pdf)

Estatísticas do modelo de negócios GPT-3

O GPT-3 não está disponível como código aberto, mas por meio de uma API comercial. Algumas das estatísticas surpreendentes sobre o status da empresa e o custo de funcionamento do GPT-3 são as seguintes:

- Em 2015, a OpenAI começou como um laboratório de pesquisa sem fins lucrativos.

- Em 2019, a OpenAI mudou de uma organização sem fins lucrativos para uma empresa com fins lucrativos [5].

- A Microsoft fez parceria com a OpenAI com um investimento de US$ 1 bilhão [12].

- O treinamento GPT-3 requer 3.114 × 1023 FLOPS (operações de ponto flutuante) que custam US$ 4.6 milhões usando uma instância de nuvem Tesla V100 a US$ 1.5/hora e levam 355 anos de GPU [13].

- O GPT-3 não pode ser treinado em uma única GPU, mas requer um sistema distribuído que aumenta o custo de treinamento do modelo final em 1.5x – 5x [14].

- O custo de P&D do GPT-3 varia de US$ 11.5 milhões a US$ 27.6 milhões, excluindo a sobrecarga de GPUs paralelas, salários e custos de submodelo [14].

- Em paralelo, o GPT-3 requer pelo menos 11 GPUs Tesla V100 com 32 GB de memória cada, a um custo de US$ 9,000/peça, totalizando US$ 99,000 para cluster de GPU, excluindo RAM, CPU, drives SSD e fonte de alimentação [13].

- O modelo GPT-3 custou US$ 12.6 milhões com pelo menos 350 GB de VRAM (FLOP de meia precisão a 16 bits/parâmetro) apenas para carregar o modelo e executar a inferência, colocando a VRAM ao norte de 400 GB [15].

- Os custos de execução do hardware seriam de US$ 100,000 a US$ 150,000, negligenciando os custos de fornecimento de energia, refrigeração e backup [14].

- Um servidor DGX-1 básico da Nvidia, VRAM (8 × 16 GB), custa cerca de US$ 130,000, incluindo todos os outros componentes para um desempenho sólido no GPT-3 [16].

- Se executado na nuvem, o GPT-3 requer pelo menos o p3dn.24xlarge da Amazon, embalado com 8xTesla V100 (32 GB), 768 GB de RAM e 96 núcleos de CPU, e custa US$ 10-30/hora e um mínimo de US$ 87,000 por ano [14] .

- A OpenAI pode trabalhar em colaboração com a Microsoft em hardware especializado, como o supercomputador, levando a soluções econômicas [14].

- O GPT-3 possui um supercomputador hospedado na nuvem Azure da Microsoft, composto por 285k núcleos de CPU e 10k GPUs de ponta [17].

- O plano de preços preliminar fornece à OpenAI uma margem de lucro de quase 6,000%, oferecendo espaço para muitos ajustes se o plano de negócios atual não atrair clientes [18].

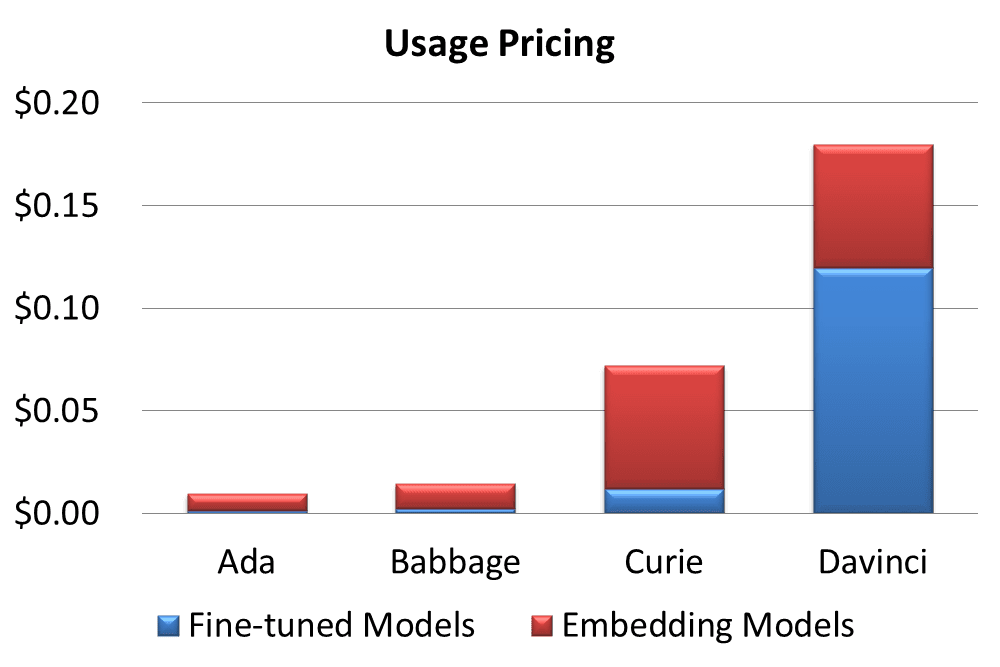

Preços GPT-3

A OpenAI oferece diversos planos de preços para sua API. Algumas das estatísticas de preços são definidas aqui,

- O GPT-3 tem um plano gratuito, Start for free, por US$ 18 em crédito grátis nos primeiros 3 meses [19].

- Dois outros planos pagos incluem um flexível 'Pague conforme o uso' e um complexo 'Escolha seu modelo' [19].

- A cobrança é feita por 1000 tokens, ou seja, cerca de 750 palavras [19]

- Um token equivale a 4 caracteres ou 0.75 palavras para texto em inglês [19].

- Cada modelo tem um comprimento de contexto máximo predefinido, variando de 1500 a 2048 tokens [20].

- Com base no espectro de capacidades e escolhas, o GPT-3 fornece 4 modelos de precificação [21].

- Ada com preço de US$ 0.0008/1K tokens, tem o desempenho mais rápido ao custo de recursos menores [21].

- Babbage custa $ 0.0012/1K tokens, é bom para tarefas simples [21].

- Curie cobrava $ 0.0060/1K tokens, tem capacidade para tarefas diferenciadas e é bom como um chatbot geral [21].

- Os tokens com preço de US$ 0.0600/1K da Davinci oferecem os melhores resultados para intenção complexa [21].

- O GPT-3 fornece um modelo de ajuste fino personalizável cobrado a 50% do preço base e um modelo de incorporação caro para criar pesquisa avançada [22,23].

|

Modelo |

Dimensões |

Preços / 1K Tokens |

Treinamento / 1K Tokens |

Uso |

Uso |

|

Ada |

1024 |

$0.0008 |

$0.0004 |

$0.0016 |

$0.0080 |

|

Babbage |

2048 |

$0.0012 |

$0.0006 |

$0.0024 |

$0.0120 |

|

Curie |

4096 |

$0.0060 |

$0.0030 |

$0.0120 |

$0.0600 |

|

Da Vinci |

12288 |

$0.0600 |

$0.0300 |

$0.1200 |

$0.0600 |

Fonte: (https://openai.com/api/pricing/)

A comercialização do GPT-3 leva várias plataformas que utilizam serviços a mudar para o modo pago:

- A PhilosopherAI declarou um custo de serviço de pelo menos US$ 4,000/mês [24].

- AI Dungeon introduziu um modelo Dragon premium para a versão baseada em GPT-3 cobrando $ 10 mensais [25].

Estatísticas de modelo personalizado GPT-3

Os clientes adaptam os modelos GPT-3 adequados às suas necessidades e obtêm resultados impressionantes. Aqui estão algumas estatísticas:

- O ajuste fino melhora a precisão sobre o conjunto de dados de problemas de matemática do Grade School em 2 a 4 vezes [26].

- As saídas corretas de um cliente aumentam de 83% para 95% [26].

- A taxa de erro de outro cliente foi reduzida em 50% com um modelo personalizado [26].

- A frequência de saídas não confiáveis é reduzida de 17% para 5% para um cliente [26].

- Os benefícios do ajuste fino do GPT-3 começam a aparecer em menos de 100 exemplos [26].

As estatísticas de aplicativos desenvolvidos pelo GPT-3 personalizado apresentam resultados promissores:

- O desempenho do Keeper Tax aumenta de 85% para 93%, com 500 novos exemplos de treinamento uma vez por semana [27].

- Relatórios viáveis melhoraram a precisão de 66% para 90% ao resumir o feedback do cliente [28].

- A geração de perguntas e conteúdo do Sana Lab rendeu uma melhoria de 60% de respostas gramaticalmente corretas para respostas altamente precisas [2].

- Elicit observa uma melhora de 24% na compreensão dos resultados, 17% na precisão e 33% no geral [26].

Arquitetura do modelo GPT-3

O modelo baseado em transformador tem uma arquitetura massiva dividida em submodelos.

- O GPT-3 possui 8 modelos baseados em tamanhos de parâmetros que variam de 125M a 175B [2].

- A arquitetura baseada em atenção possui camadas de atenção que variam de 12 no menor modelo a 96 no maior [2].

- As camadas do transformador variam de 12 a 96 [2].

- A taxa de aprendizado muda de 6.0 × 10-4 para 0.6 × 10-4 [2].

|

Modelo |

Parâmetros treináveis |

Camadas de Transformador |

Unidades de camada de gargalo |

Camadas de Atenção |

Atenção Dimensão da Cabeça |

Tamanho do batch |

Taxa de Aprendizagem |

|

GRT-3 Pequeno |

125M |

12 |

768 |

12 |

64 |

0.5M |

× 6.0 10-4 |

|

GRT-3 Médio |

350M |

24 |

1024 |

24 |

64 |

0.5M |

× 3.0 10-4 |

|

GRT-3 Grande |

760M |

24 |

1536 |

24 |

96 |

0.5M |

× 2.5 10-4 |

|

GRT-3XL |

1.3B |

24 |

2048 |

24 |

128 |

1M |

× 2.0 10-4 |

|

GRT-3 2.7B |

2.7B |

32 |

2560 |

32 |

80 |

1M |

× 1.6 10-4 |

|

GRT-3 6.7B |

6.7B |

32 |

4096 |

32 |

128 |

2M |

× 1.2 10-4 |

|

GRT-3 13B |

13.0B |

40 |

5140 |

40 |

128 |

2M |

× 1.0 10-4 |

|

GRT-3 175B |

175.0B |

96 |

12288 |

96 |

128 |

2M |

× 0.6 10-4 |

Fonte: https://arxiv.org/pdf/2005.14165.pdf

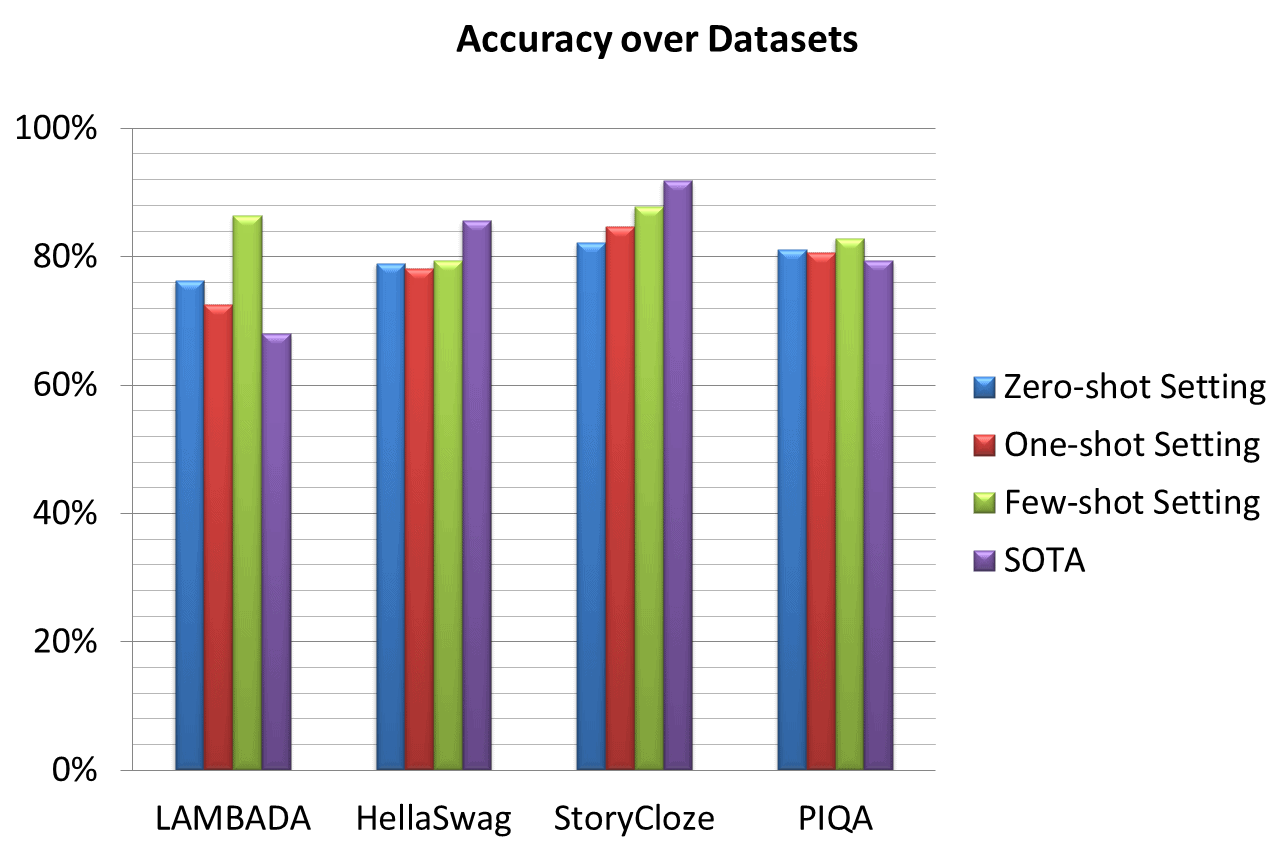

Desempenho e Precisão da GPT-3

O desempenho e a precisão do GPT-3 são estudados em vários conjuntos de dados existentes. As estatísticas de desempenho interessantes são as seguintes:

- Melhoria significativa de desempenho é descrita sobre LAMBADA e PhysicalQA (PIQA) [2].

- Um ganho proeminente de 8% é alcançado no ajuste zero-shot LAMBADA pelo GPT-3 comparado ao SOTA [2].

- Uma precisão significativamente melhorada de 4% é descrita para o PIQA em comparação com o SOTA anterior – um RoBERTa ajustado [2].

- HellaSwag e StoryCloze apresentaram desempenho respeitável, mas ainda inferior ao SOTA [2].

- Os resultados do HellaSwag são mais baixos em comparação com o modelo multitarefa ajustado ALUM [29].

- O StoryCloze está 4.1% atrás do SOTA usando o modelo BERT ajustado [29].

- Winograd mostra 88.3%, 89.7% e 88.6% nas configurações de tiro zero, um tiro e poucos tiros, respectivamente, e mostrando resultados fortes, mas abaixo de SOTA [13].

- GPT-3 Modelo de ajuste fino mostra 100% de precisão para adição e subtração de dois dígitos [11].

- Artigos curtos (~200 palavras) escritos por GPT-3 175B são humanamente detectáveis para mudanças em ~52% [13].

- Os artigos escritos por GPT-3 125M são 76% detectáveis em humanos. ([13])

|

Conjunto de dados |

Configuração de tiro zero |

Configuração de um tiro |

Configuração de poucos tiros |

SOTA |

|

LAMBADA |

76.2% |

72.5% |

86.4% |

68% |

|

HellaSwag |

78.9% |

78.1% |

79.3% |

85.6% |

|

História Fechar |

82.2% |

84.7% |

87.7% |

91.8% |

|

QA Físico (PIQA) |

81.0% |

80.5% |

82.8% |

79.4% |

Fonte: https://www.springboard.com/blog/data-science/machine-learning-gpt-3-open-ai/

Plataformas alimentadas por GPT-3

Alguns dos negócios e aplicativos que utilizam o GPT-3 são mencionados em Estatísticas de modelo personalizado e Estatísticas de preços. As estatísticas de mais algumas plataformas e aplicativos desenvolvidos pelo GPT-3 são indicadas abaixo:

- O GPT-3 está sendo utilizado por mais de 300 aplicativos [30]

- A plataforma tem dezenas de milhares de desenvolvedores em todo o mundo [11].

- Em março de 2021, uma média de 4.5 bilhões de palavras são geradas por dia [30].

- Algolia testou o GPT-3 em 2.1 milhões de artigos de notícias e obteve 91% de precisão [30].

- O Duolingo usando GPT-3 observou uma melhoria de 12% na precisão da previsão e no engajamento do usuário [31].

- DALL·E 2 baseado em 12B GPT-3 é preferido por 71.7% dos usuários para correspondência de legendas e por 88.8% para realismo fotográfico [32].

Casos de uso da GPT-3

O GPT-3 é um novo sistema de inteligência artificial que se diz ser o sistema de IA mais poderoso do mundo. O GPT-3 tem muitos usos em potencial, incluindo ajudar humanos em seu trabalho, fornecer melhor atendimento ao cliente e até se tornar um assistente pessoal. Aqui estão alguns dos casos comuns de uso do GPT-3:

O negócio

O GPT-3, o maior modelo de inteligência artificial do mundo, já está disponível ao público. E as empresas estão percebendo. As empresas já estão usando a IA para melhorar o atendimento ao cliente, criar novos produtos e automatizar tarefas repetitivas.

Marketing

GPT-3 é uma ferramenta poderosa para marketing. Ferramentas de marketing de IA pode ajudá-lo a criar conteúdo melhor, direcionar seu público-alvo de forma mais eficaz e acompanhar seus resultados. Além disso, o GPT-3 pode ajudá-lo a acompanhar seu progresso e analisar seus resultados para que você possa otimizar suas estratégias de marketing.

Atendimento ao Cliente

A IA no atendimento ao cliente está revolucionando a forma como as empresas interagem com seus clientes. Ao automatizar tarefas de rotina e fornecer respostas instantâneas a perguntas comuns, a IA está ajudando as empresas a melhorar sua experiência de atendimento ao cliente. Além disso, os chatbots com tecnologia GPT-3 podem lidar com consultas complexas de clientes, liberando agentes humanos para fornecer um serviço mais personalizado.

A análise dos dados

A IA pode ajudar a identificar padrões e correlações que os humanos podem perder. Também pode ajudar a automatizar o processo de análise, tornando-o mais rápido e fácil. Além disso, a IA pode fornecer insights que não seriam possíveis sem sua ajuda. Por esses motivos, a IA está se tornando uma ferramenta essencial para analistas de dados.

Criação de Conteúdo

Baseado em GPT-3 Ferramentas de criação de conteúdo de IA estão sendo usados para escrever artigos, criar vídeos e até mesmo gerar postagens de mídia social.

Design

Ferramentas de design de IA powered by GPT-3 têm o potencial de melhorar a eficiência e a qualidade do processo de projeto automatizando tarefas repetitivas, fornecendo recomendações personalizadas e auxiliando na exploração de opções de projeto.

Palavras finais das estatísticas da GPT-3

O artigo fornece a história de crescimento do GPT-3 com base em estatísticas proeminentes. Os modelos GPT-n estão crescendo substancialmente e a comunidade de pesquisa está curiosa sobre o GPT-4. De acordo com um revisor do Hacker News,

“Um cérebro humano típico tem mais de 100 trilhões de sinapses, que são outras três ordens de magnitude maiores que o modelo GPT-3 175B. Dado que o OpenAI leva cerca de um ano e um quarto para aumentar sua capacidade de modelo GPT em duas ordens de magnitude de 1.5 bilhão para 175 bilhões, ter modelos com trilhões de peso de repente parece promissor.”

Referências

- https://medium.com/walmartglobaltech/the-journey-of-open-ai-gpt-models-32d95b7b7fb2

- https://arxiv.org/pdf/2005.14165.pdf

- https://openai.com/blog/gpt-3-apps/

- https://towardsdatascience.com/gpt-3-a-complete-overview-190232eb25fd

- (https://futurism.com/ai-elon-musk-openai-profit)

- https://www.toptal.com/deep-learning/exploring-pre-trained-models

- https://www.gartner.com/en/documents/3994660

- (https://www.i-programmer.info/news/105-artificial-intelligence/14987-the-third-age-of-ai-megatron-turing-nlg.html)

- (https://360digitmg.com/gpt-vs-bert

- https://www.datacamp.com/blog/gpt-3-and-the-next-generation-of-ai-powered-services

- (https://singularityhub.com/2021/04/04/openais-gpt-3-algorithm-is-now-producing-billions-of-words-a-day/)

- (https://www.theverge.com/2019/7/22/20703578/microsoft-openai-investment-partnership-1-billion-azure-artificial-general-intelligence-agi)

- https://lambdalabs.com/blog/demystifying-gpt-3/

- https://bdtechtalks.com/2020/09/21/gpt-3-economy-business-model/

- https://cloudxlab.com/blog/what-is-gpt3-and-will-it-take-over-the-world/

- https://medium.com/@messisahil7/gpt-3-a-new-step-towards-general-artificial-intelligence-66879e1c4a44

- https://www.endila.com/post/is-gpt-3-really-the-future-of-nlp

- https://pakodas.substack.com/p/estimating-gpt3-api-cost?s=r

- https://openai.com/api/pricing/

- https://beta.openai.com/docs/introduction/key-concepts

- https://beta.openai.com/docs/models

- https://beta.openai.com/docs/guides/fine-tuning,

- https://beta.openai.com/docs/guides/embeddings/what-are-embeddings

- https://philosopherai.com/

- (https://aidungeon.medium.com/ai-dungeon-dragon-model-upgrade-7e8ea579abfe

- https://openai.com/blog/customized-gpt-3/

- ((https://www.keepertax.com/

- https://www.askviable.com/

- https://www.springboard.com/blog/data-science/machine-learning-gpt-3-open-ai/

- https://openai.com/blog/gpt-3-apps

- https://www.wired.com/brandlab/2018/12/ai-helps-duolingo-personalize-language-learning/

- https://openai.com/dall-e-2/

Patryk Miszczak