Estadísticas de GPT-3 2023: uso, parámetros, casos de uso y más

GPT-3, una iniciativa de OpenAI, es la tercera variante en la línea de la serie GPT-n y se considera el modelo de lenguaje más poderoso hasta la fecha.

Esta nueva tecnología de IA se puede utilizar para una variedad de tareas y ahora está disponible para el público.

Investigamos y recopilamos las últimas estadísticas de GPT-3. Descubrirá cómo esta nueva tecnología está cambiando el panorama de la inteligencia artificial.

- , AI

Principales estadísticas de GPT-3

Algunas de las estadísticas interesantes de GPT-3 se indican a continuación:

- GPT-3 está muy por delante de los modelos existentes con parámetros entrenables 175B [1].

- GPT-3 tiene los datos de entrenamiento más grandes, la friolera de 45 TB [2].

- GPT-3 está siendo utilizado por más de 300 aplicaciones [3].

- A partir de marzo de 2021, se genera un promedio de 4.5 millones de palabras por día [3].

- Algolia probó GPT-3 en 2.1 millones de artículos de noticias y obtuvo una precisión del 91 % [3].

- GPT-3 es 117 veces más complejo que GPT-2 [10].

Modelos y parámetros de GPT-3

Varios Procesamiento natural del lenguaje los modelos están disponibles y siguen evolucionando. Las estadísticas destacadas de clasificación de GPT-3 en términos de varios modelos son las siguientes:

- Los recursos de entrenamiento del modelo de aprendizaje profundo se duplicaron cada 3.4 meses durante la última década [4].

- Se observa un aumento de 300K veces en los recursos computacionales entre 2012 y 2018 [4].

- Actualmente, GPT-3 tiene el corpus de datos más grande de 45 TB entrenado con 499 mil millones de tokens [2].

- Un modelo T5 anterior se entrenó solo con un conjunto de datos de 7 TB [6].

- GPT-3 tiene parámetros entrenables 175B [1].

- La tecnología disruptiva de GPT-3 muestra que ~70 % del desarrollo de software se puede automatizar [7].

- Los modelos anteriores de NLP, ELMo, tenían 94M de parámetros, BERT tenía 340M, GPT-2 tenía 1.5B y Turing NLG tenía 17B [8].

- BERT de Google tiene 470 veces menos parámetros que GPT-3 [9].

- GPT-3 contiene 100 veces más parámetros que su predecesor GPT-2 [1].

- GPT-3 tiene 10 veces más parámetros que el modelo Turing NLG de Microsoft [1].

- La capacidad de los modelos GPT-n se mejora en 3 órdenes de magnitud con GPT-3.

- GPT-3 es 117x más complejo que GPT-2 [10].

- GPT-3 superó a SOTA para el conjunto de datos LAMBDA con una mejora de eficiencia del 8 % [2].

- En comparación con SOTA, que proporciona una precisión del 60 % para sumas y restas de dos dígitos, el modelo ajustado GPT-3 representa el 100 % [11].

- Algolia basado en GPT-3 responde con precisión preguntas complejas de lenguaje natural 4 veces mejor que BERT [3].

- A partir de noviembre de 2021, Microsoft ha anunciado un modelo más grande Megatron-Turing NLG con parámetros 530B [8].

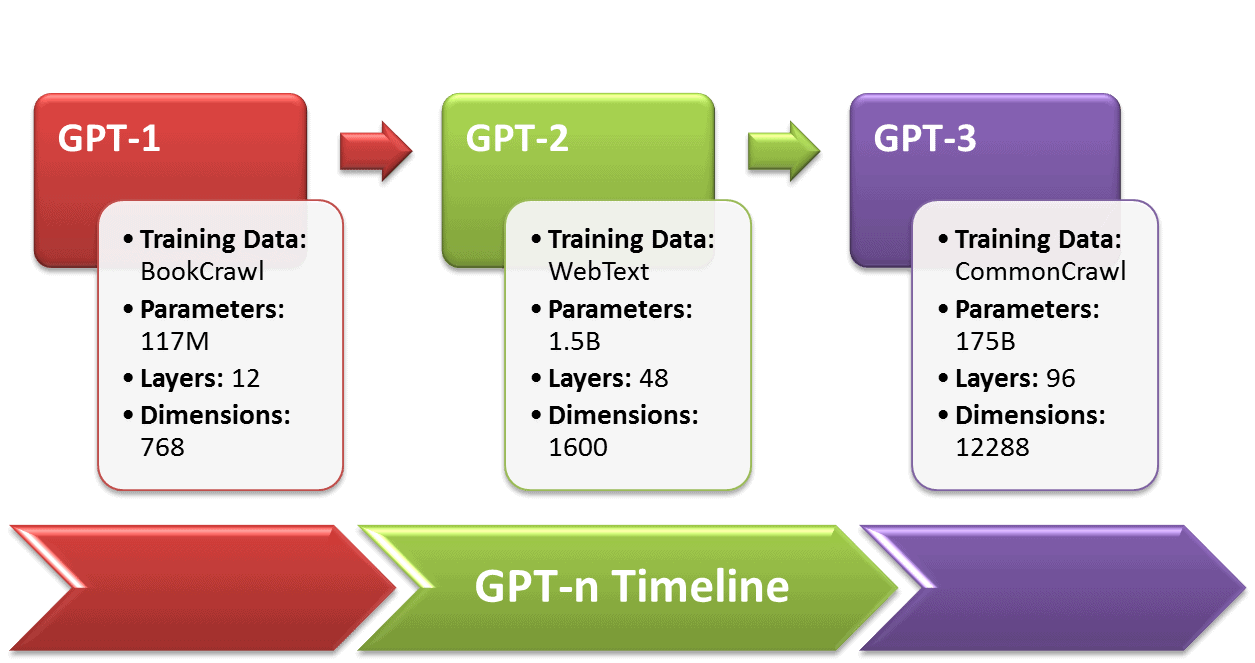

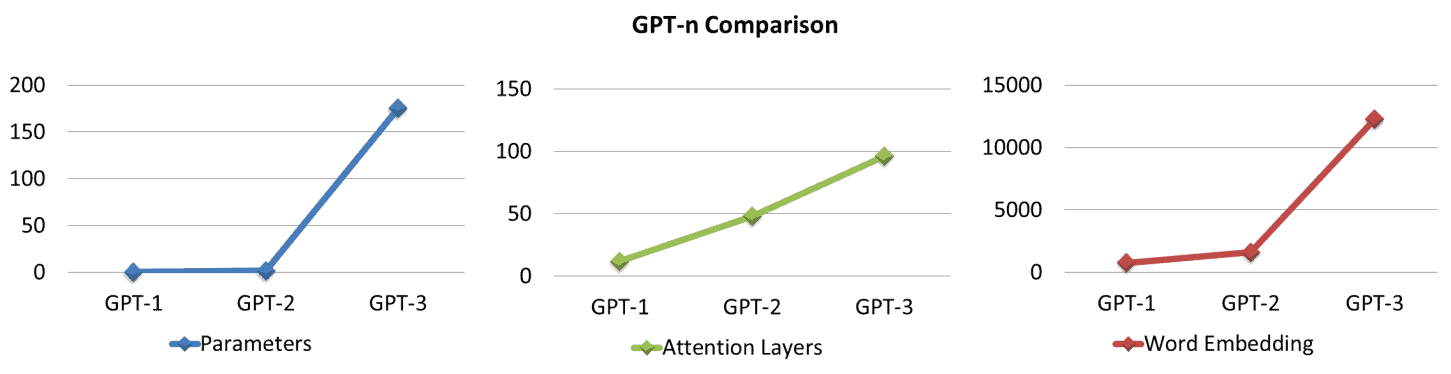

Cronología de GPT-n

En 2018, OpenAI inició la serie GPT-n para mejorar los modelos NLP, es decir, voz, texto y codificación similares a los humanos. A continuación se proporciona una comparación estadística de GPT-n: [1]

- GPT-1 tiene 12 capas con 12 cabezas de atención y un estado de 768 dimensiones.

- Los datos de entrenamiento de GPT-1, BooksCorpus, tenían casi 7000 libros no publicados que suman ~5 GB de texto.

- GPT-1 se desempeñó bien en 9 de 12 tareas en comparación con los modelos SOTA supervisados junto con un rendimiento decente de tiro cero en varias tareas.

- GPT-2, un sucesor de GPT-1 lanzado en 2019, está capacitado en 10 veces los parámetros y la cantidad de datos que GPT-1.

- GPT-2 tiene 1.5B de parámetros y un conjunto de datos de 40GB, WebText, incluidas 8 millones de páginas web.

- GPT-2 proporcionó resultados mejorados para 7 de los 8 modelos SOTA existentes y también funcionó bien en la configuración de disparo cero.

- GPT-3 supera a los modelos de lenguaje anteriores con parámetros 100 veces mayores que GPT-2.

- GPT-3 tiene 175B de parámetros entrenables y 12288 palabras incrustadas (dimensiones).

|

Modelo |

Lanzamiento Año |

Datos de muestra |

Parámetros de entrenamiento |

Capas de atención |

Incrustación de palabras |

Cabezas de atención |

|

GPT-1 |

2018 |

7000 Libros ~5GB |

117 m |

12 |

768 |

12 |

|

GPT-2 |

2019 |

8 millones de documentos ~40GB |

1.5B |

48 |

1600 |

48 |

|

GPT-3 |

2020 |

Múltiples fuentes ~45 TB |

175B |

96 |

12288 |

96 |

Estadísticas del modelo de entrenamiento GPT-3

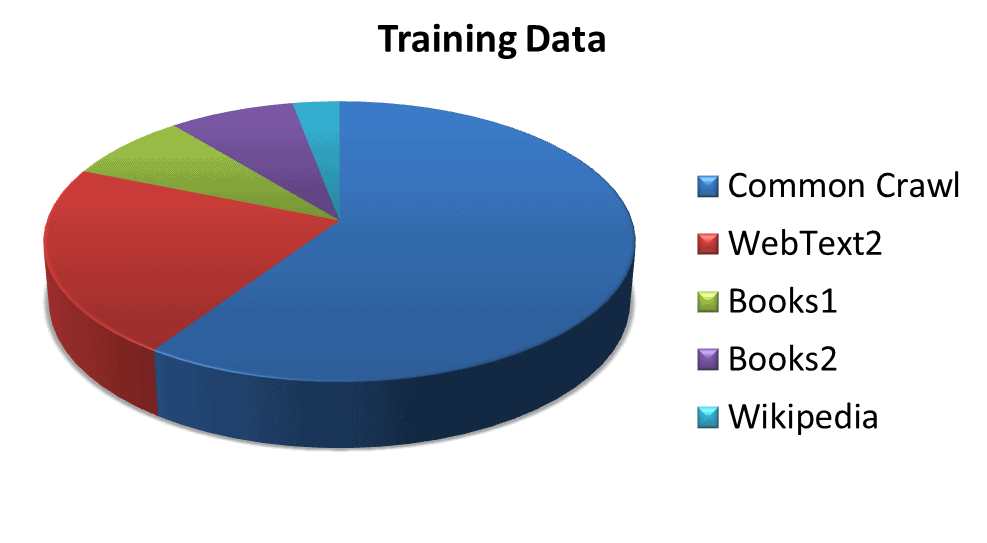

Las estadísticas de varios conjuntos de datos utilizados para entrenar el modelo son las siguientes:

- GPT-3 está entrenado con un total de tokens de 499B, o 700GB [2].

- Rastreo común con una ponderación del 60 %, contiene diversos datos del rastreo web a lo largo de los años [2].

- WebTexto2 que abarca el 22%, incluye el conjunto de datos de los enlaces salientes de Reddit [2].

- Libros1 y Libros2 con una participación combinada del 16%, contienen corpus de libros basados en Internet [2].

- Wikipedia ponderado al 3%, incluye datos de páginas de Wikipedia en inglés [2].

|

Conjunto de datos |

Tokens |

Ponderación del conjunto de datos en el entrenamiento |

|

Common Crawl (filtrado) |

Más de 410 mil millones |

60% |

|

WebTexto2 |

Más de 19 mil millones |

22% |

|

Libros1 |

Más de 12 mil millones |

8% |

|

Libros2 |

Más de 55 mil millones |

8% |

|

Wikipedia |

Más de 3 mil millones |

3% |

Fuente: (https://arxiv.org/pdf/2005.14165.pdf)

Estadísticas del modelo de negocio GPT-3

GPT-3 no está disponible como código abierto sino a través de una API comercial. Algunas de las estadísticas sorprendentes sobre el estado de la empresa y el costo de funcionamiento de GPT-3 son las siguientes:

- En 2015, OpenAI comenzó como un laboratorio de investigación sin fines de lucro.

- En 2019, OpenAI pasó de ser una organización sin fines de lucro a una empresa con fines de lucro [5].

- Microsoft se asoció con OpenAI con una inversión de mil millones de dólares [1].

- El entrenamiento de GPT-3 requiere 3.114 × 1023 FLOPS (operaciones de punto flotante) que cuestan $ 4.6M usando una instancia de nube Tesla V100 a $ 1.5 / hora y toman 355 años de GPU [13].

- GPT-3 no se puede entrenar en una sola GPU, pero requiere un sistema distribuido que aumenta el costo de entrenar el modelo final entre 1.5 y 5 veces [14].

- El costo de I+D de GPT-3 oscila entre $11.5 millones y $27.6 millones, sin incluir los gastos generales de las GPU paralelas, los salarios y los costos de los submodelos [14].

- Paralelamente, GPT-3 requiere al menos 11 GPU Tesla V100 con 32 GB de memoria cada una, a un costo de $ 9,000 por pieza que suma $ 99,000 por clúster de GPU sin incluir RAM, CPU, unidades SSD y fuente de alimentación [13].

- El modelo GPT-3 cuesta 12.6 millones de dólares con al menos 350 GB de VRAM (FLOP de precisión media a 16 bits/parámetro) solo para cargar el modelo y ejecutar la inferencia, colocando la VRAM por encima de los 400 GB [15].

- Los costos de funcionamiento del hardware serían de $ 100,000 a $ 150,000 sin tener en cuenta los costos de suministro de energía, enfriamiento y respaldo [14].

- Un servidor DGX-1 de Nvidia de referencia, VRAM (8 × 16 GB), cuesta alrededor de $ 130,000, incluidos todos los demás componentes para un rendimiento sólido en GPT-3 [16].

- Si se ejecuta en la nube, GPT-3 requiere al menos p3dn.24xlarge de Amazon, equipado con 8xTesla V100 (32 GB), 768 GB de RAM y 96 núcleos de CPU, y cuesta $10-30/hora, y un mínimo de $87,000 14 al año [XNUMX] .

- OpenAI puede trabajar en colaboración con Microsoft en hardware especializado, como la supercomputadora que conduce a soluciones rentables [14].

- GPT-3 tiene una supercomputadora alojada en la nube Azure de Microsoft, que consta de 285 10 núcleos de CPU y 17 XNUMX GPU de gama alta [XNUMX].

- El plan de precios preliminar proporciona a OpenAI un margen de beneficio de casi el 6,000 %, lo que brinda espacio para muchos ajustes si el plan comercial actual no atrae clientes [18].

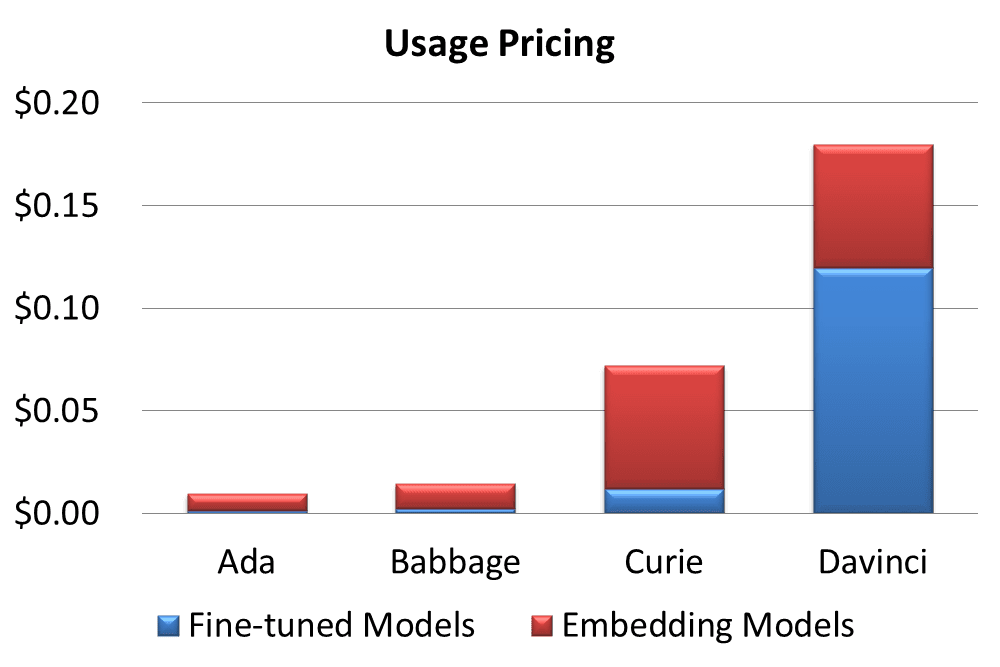

Precios de GPT-3

OpenAI ofrece diversos planes de precios para su API. Algunas de las estadísticas de precios se definen aquí,

- GPT-3 tiene un plan gratuito, Comience gratis, por $18 en crédito gratis durante los primeros 3 meses [19].

- Otros dos planes pagos incluyen un 'Pago por uso' flexible y un complejo 'Elige tu modelo' [19].

- La facturación se realiza por 1000 tokens, es decir, unas 750 palabras [19]

- Un token equivale a 4 caracteres o 0.75 palabras para texto en inglés [19].

- Cada modelo tiene una longitud de contexto máxima predefinida, que va de 1500 a 2048 tokens [20].

- Según el espectro de capacidades y opciones, GPT-3 proporciona 4 modelos de precios [21].

- Ada, con un precio de $0.0008/1K tokens, se desempeña más rápido al costo de capacidades menores [21].

- Babbage cuesta $0.0012/1K tokens, es bueno para tareas sencillas [21].

- Curie cobró $ 0.0060 / 1K tokens, tiene la capacidad de realizar tareas matizadas y es bueno como un chatbot general [21].

- Los tokens Davinci con un precio de $0.0600/1K brindan los mejores resultados para la intención compleja [21].

- GPT-3 proporciona un modelo de ajuste fino personalizable facturado al 50 % del precio base y un modelo de incrustación costoso para crear una búsqueda avanzada [22,23].

|

Modelo |

Dimensiones |

Precios / 1K tokens |

Entrenamiento / Fichas 1K |

Uso |

Uso |

|

Ada |

1024 |

$0.0008 |

$0.0004 |

$0.0016 |

$0.0080 |

|

Babbage |

2048 |

$0.0012 |

$0.0006 |

$0.0024 |

$0.0120 |

|

Curie |

4096 |

$0.0060 |

$0.0030 |

$0.0120 |

$0.0600 |

|

Da Vinci |

12288 |

$0.0600 |

$0.0300 |

$0.1200 |

$0.0600 |

Fuente: (https://openai.com/api/pricing/)

La comercialización de GPT-3 lleva a varias plataformas que utilizan servicios a cambiar al modo pago:

- PhilosopherAI declaró un costo de servicio de al menos $4,000/mes [24].

- AI Dungeon ha presentado un Dragon Model premium para la versión basada en GPT-3 que cobra $10 mensuales [25].

Estadísticas del modelo personalizado GPT-3

Los clientes adaptan los modelos GPT-3 a sus necesidades y obtienen resultados sorprendentes. Aquí hay algunas estadísticas:

- El ajuste fino mejora la precisión sobre el conjunto de datos de problemas de matemáticas de la escuela primaria de 2 a 4 veces [26].

- Los resultados correctos de un cliente aumentan del 83 % al 95 % [26].

- La tasa de error de otro cliente se redujo en un 50 % con un modelo personalizado [26].

- La frecuencia de salidas no confiables se reduce del 17 % al 5 % para un cliente [26].

- Los beneficios del ajuste fino de GPT-3 comienzan a aparecer en menos de 100 ejemplos [26].

Las estadísticas de aplicaciones impulsadas por GPT-3 personalizado muestran resultados prometedores:

- El rendimiento de Keeper Tax mejora del 85 % al 93 %, con 500 nuevos ejemplos de capacitación una vez por semana [27].

- Los informes viables mejoraron la precisión del 66 % al 90 % al resumir los comentarios de los clientes [28].

- La generación de contenido y preguntas de Sana Lab arrojó una mejora del 60 % de respuestas gramaticalmente correctas generales a respuestas altamente precisas [2].

- Elicit observa una mejora del 24 % en la comprensión de los resultados, del 17 % en la precisión y del 33 % en general [26].

Arquitectura modelo GPT-3

El modelo basado en transformador tiene una arquitectura masiva dividida en submodelos.

- GPT-3 tiene 8 modelos basados en tamaños de parámetros que van desde 125M a 175B [2].

- La arquitectura basada en la atención tiene capas de atención que van desde 12 en el modelo más pequeño hasta 96 en el más grande [2].

- Las capas del transformador van de 12 a 96 [2].

- Cambios en la tasa de aprendizaje de 6.0 × 10-4 a 0.6 × 10-4 [2].

|

Modelo |

Parámetros entrenables |

Capas de transformador |

Unidades de capa de cuello de botella |

Capas de atención |

Dimensión de la cabeza de atención |

Tamaño del lote |

Tasa de aprendizaje |

|

TRB-3 pequeño |

125 m |

12 |

768 |

12 |

64 |

0.5 m |

× 6.0 10-4 |

|

TRB-3 Medio |

350 m |

24 |

1024 |

24 |

64 |

0.5 m |

× 3.0 10-4 |

|

TRB-3 grande |

760 m |

24 |

1536 |

24 |

96 |

0.5 m |

× 2.5 10-4 |

|

TRB-3 XL |

1.3B |

24 |

2048 |

24 |

128 |

1M |

× 2.0 10-4 |

|

TRB-3 2.7B |

2.7B |

32 |

2560 |

32 |

80 |

1M |

× 1.6 10-4 |

|

TRB-3 6.7B |

6.7B |

32 |

4096 |

32 |

128 |

2M |

× 1.2 10-4 |

|

TRB-3 13B |

13.0B |

40 |

5140 |

40 |

128 |

2M |

× 1.0 10-4 |

|

TRB-3 175B |

175.0B |

96 |

12288 |

96 |

128 |

2M |

× 0.6 10-4 |

Fuente: https://arxiv.org/pdf/2005.14165.pdf

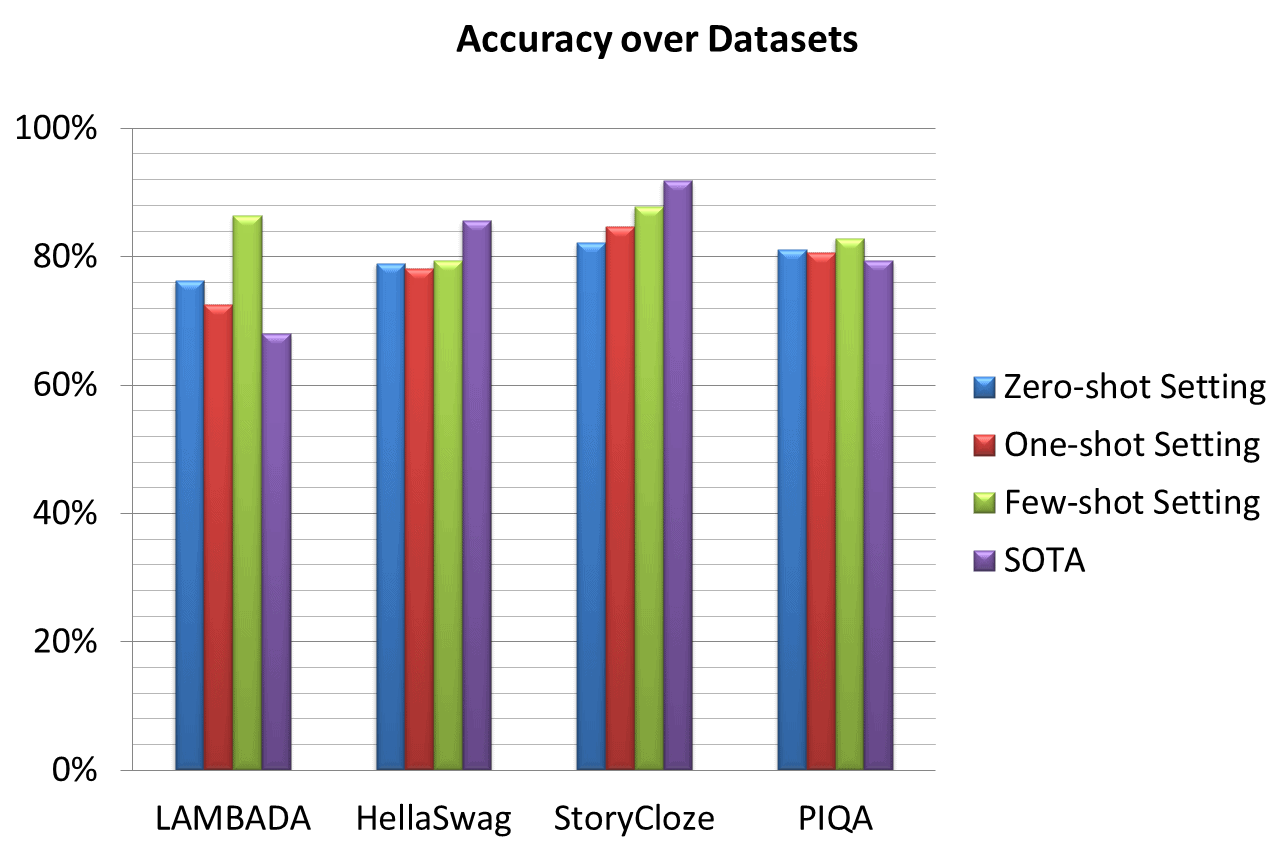

Rendimiento y precisión de GPT-3

El rendimiento y la precisión de GPT-3 se estudian en varios conjuntos de datos existentes. Las estadísticas de rendimiento interesantes son las siguientes:

- Se muestra una mejora significativa del rendimiento con respecto a LAMBADA y PhysicalQA (PIQA) [2].

- Se logra una ganancia destacada del 8% en la configuración de tiro cero LAMBADA por GPT-3 en comparación con SOTA [2].

- Se muestra una precisión sustancialmente mejorada del 4% para PIQA en comparación con SOTA anterior: un RoBERTa ajustado [2].

- HellaSwag y StoryCloze mostraron un rendimiento respetable, pero aún inferior al de SOTA [2].

- Los resultados de HellaSwag son más bajos en comparación con el modelo multitarea ALUM [29].

- StoryCloze está un 4.1 % por debajo de la SOTA utilizando el modelo BERT ajustado [29].

- Winograd muestra 88.3 %, 89.7 % y 88.6 % en las configuraciones de disparo cero, disparo único y pocos disparos, respectivamente, y presenta resultados sólidos pero por debajo de SOTA [13].

- El modelo de ajuste fino GPT-3 muestra una precisión del 100 % para sumas y restas de dos dígitos [11].

- Los artículos breves (~200 palabras) escritos por GPT-3 175B son humanamente detectables por cambios en ~52% [13].

- Los artículos escritos por GPT-3 125M son 76% detectables por humanos. ([13])

|

Conjunto de datos |

Configuración de tiro cero |

Configuración de un disparo |

Configuración de pocos disparos |

SO |

|

LAMBADA |

76.2% |

72.5% |

86.4% |

68% |

|

hellaswag |

78.9% |

78.1% |

79.3% |

85.6% |

|

HistoriaCloze |

82.2% |

84.7% |

87.7% |

91.8% |

|

Control de calidad físico (PIQA) |

81.0% |

80.5% |

82.8% |

79.4% |

Fuente: https://www.springboard.com/blog/data-science/machine-learning-gpt-3-open-ai/

Plataformas motorizadas GPT-3

Algunas de las empresas y aplicaciones que utilizan GPT-3 se mencionan en Estadísticas de modelos personalizados y Estadísticas de precios. Las estadísticas de algunas plataformas y aplicaciones más con tecnología GPT-3 se indican a continuación:

- GPT-3 está siendo utilizado por más de 300 aplicaciones [30]

- La plataforma tiene decenas de miles de desarrolladores en todo el mundo [11].

- A partir de marzo de 2021, se genera un promedio de 4.5 millones de palabras por día [30].

- Algolia probó GPT-3 en 2.1 millones de artículos de noticias y obtuvo una precisión del 91 % [30].

- Duolingo usando GPT-3 observó una mejora del 12 % en la precisión de la predicción y la participación del usuario [31].

- DALL·E 2 basado en 12B GPT-3 es preferido por el 71.7% de los usuarios para la coincidencia de subtítulos y por el 88.8% para el realismo fotográfico [32].

Casos de uso de GPT-3

GPT-3 es un nuevo sistema de inteligencia artificial que se dice que es el sistema de IA más poderoso del mundo. GPT-3 tiene muchos usos potenciales, que incluyen ayudar a los humanos con su trabajo, brindar un mejor servicio al cliente e incluso convertirse en un asistente personal. Estos son algunos de los casos de uso comunes de GPT-3:

Empresa

GPT-3, el modelo de inteligencia artificial más grande del mundo, ya está disponible para el público. Y las empresas se están dando cuenta. Las empresas ya están utilizando IA para mejorar el servicio al cliente, crear nuevos productos y automatizar tareas repetitivas.

Marketing

GPT-3 es una poderosa herramienta de marketing. Herramientas de marketing de IA puede ayudarlo a crear mejor contenido, dirigirse a su audiencia de manera más efectiva y realizar un seguimiento de sus resultados. Además, GPT-3 puede ayudarlo a realizar un seguimiento de su progreso y analizar sus resultados para que pueda optimizar sus estrategias de marketing.

Servicio al Cliente

La IA en el servicio al cliente está revolucionando la forma en que las empresas interactúan con sus clientes. Al automatizar tareas rutinarias y brindar respuestas instantáneas a preguntas comunes, la IA está ayudando a las empresas a mejorar su experiencia de servicio al cliente. Además, los chatbots con tecnología GPT-3 pueden manejar consultas complejas de los clientes, lo que libera a los agentes humanos para brindar un servicio más personalizado.

El análisis de datos

La IA puede ayudar a identificar patrones y correlaciones que los humanos podrían pasar por alto. También puede ayudar a automatizar el proceso de análisis, haciéndolo más rápido y fácil. Además, la IA puede proporcionar información que no sería posible sin su ayuda. Por estas razones, la IA se está convirtiendo en una herramienta esencial para los analistas de datos.

Creación de contenidos

basado en GPT-3 Herramientas de creación de contenido de IA se están utilizando para escribir artículos, crear videos e incluso generar publicaciones en las redes sociales.

Diseño

Herramientas de diseño de IA impulsado por GPT-3 tiene el potencial de mejorar la eficiencia y la calidad del proceso de diseño al automatizar tareas repetitivas, proporcionar recomendaciones personalizadas y ayudar en la exploración de opciones de diseño.

Estadísticas de GPT-3 Palabras finales

El artículo proporciona la historia de crecimiento de GPT-3 basada en estadísticas destacadas. Los modelos GPT-n están creciendo sustancialmente y la comunidad de investigación siente curiosidad por GPT-4. Según un crítico de Hacker News,

“Un cerebro humano típico tiene más de 100 billones de sinapsis, que son otros tres órdenes de magnitud más grandes que el modelo GPT-3 175B. Dado que a OpenAI le toma aproximadamente un año y cuarto aumentar la capacidad de su modelo GPT en dos órdenes de magnitud de 1.5B a 175B, tener modelos con billones de peso de repente parece prometedor".

Referencias

- https://medium.com/walmartglobaltech/the-journey-of-open-ai-gpt-models-32d95b7b7fb2

- https://arxiv.org/pdf/2005.14165.pdf

- https://openai.com/blog/gpt-3-apps/

- https://towardsdatascience.com/gpt-3-a-complete-overview-190232eb25fd

- (https://futurism.com/ai-elon-musk-openai-profit)

- https://www.toptal.com/deep-learning/exploring-pre-trained-models

- https://www.gartner.com/en/documents/3994660

- (https://www.i-programmer.info/news/105-artificial-intelligence/14987-the-third-age-of-ai-megatron-turing-nlg.html)

- (https://360digitmg.com/gpt-vs-bert

- https://www.datacamp.com/blog/gpt-3-and-the-next-generation-of-ai-powered-services

- (https://singularityhub.com/2021/04/04/openais-gpt-3-algorithm-is-now-producing-billions-of-words-a-day/)

- (https://www.theverge.com/2019/7/22/20703578/microsoft-openai-investment-partnership-1-billion-azure-artificial-general-intelligence-agi)

- https://lambdalabs.com/blog/demystifying-gpt-3/

- https://bdtechtalks.com/2020/09/21/gpt-3-economy-business-model/

- https://cloudxlab.com/blog/what-is-gpt3-and-will-it-take-over-the-world/

- https://medium.com/@messisahil7/gpt-3-a-new-step-towards-general-artificial-intelligence-66879e1c4a44

- https://www.endila.com/post/is-gpt-3-really-the-future-of-nlp

- https://pakodas.substack.com/p/estimating-gpt3-api-cost?s=r

- https://openai.com/api/pricing/

- https://beta.openai.com/docs/introduction/key-concepts

- https://beta.openai.com/docs/models

- https://beta.openai.com/docs/guides/fine-tuning,

- https://beta.openai.com/docs/guides/embeddings/what-are-embeddings

- https://philosopherai.com/

- (https://aidungeon.medium.com/ai-dungeon-dragon-model-upgrade-7e8ea579abfe

- https://openai.com/blog/customized-gpt-3/

- ((https://www.keepertax.com/

- https://www.askviable.com/

- https://www.springboard.com/blog/data-science/machine-learning-gpt-3-open-ai/

- https://openai.com/blog/gpt-3-apps

- https://www.wired.com/brandlab/2018/12/ai-helps-duolingo-personalize-language-learning/

- https://openai.com/dall-e-2/

Patryk Miszczak