19 AutoML-Tools zum einfachen Trainieren Ihrer ML-Modelle [2023]

Tools für automatisiertes maschinelles Lernen (AutoML) ermöglichen Unternehmen die schnelle, präzise und kontinuierliche Erweiterung und Anwendung von maschinellen Lernmodellen auf höchstem Rang in ihren Betrieben, um reale Probleme zu markieren, anstatt einfach mit Datenwissenschaftlern zu verhandeln, um Modelle von Hand zu codieren.

In diesem Artikel werden wir uns 19 leistungsstarke AutoML-Tools ansehen, die in der Welt der Datenwissenschaft und des maschinellen Lernens ziemlich bekannt sind.

- , Software

AutoML umfasst möglicherweise jede Phase von der Entstehung mit einem kleinen Datensatz bis zur Erstellung eines maschinellen Lernmodells, das für die Nutzung leicht verfügbar ist.

Darüber hinaus wurde AutoML als auf künstlicher Intelligenz basierende Lösung für die wachsende Nachfrage nach der Anwendung von maschinellem Lernen vorgeschlagen.

Die Technik, die zur Herstellung von Geräten in AutoML verwendet wird, konzentrierte sich darauf, Laien die Nutzung von Modellen und Techniken des maschinellen Lernens zu ermöglichen, ohne sie zu zwingen, Profis im maschinellen Lernen zu werden.

Jetzt stellen wir die besten AutoML-Tools vor, die Sie in Ihre Geschäftsstrategie integrieren können, um sicherzustellen, dass Sie immer einen Schritt voraus sind.

Aber bevor Sie eintauchen, möchten Sie vielleicht unseren vorherigen Artikel über verschiedene Themen lesen KI-Business-Tools für ein umfassendes Verständnis der breiteren KI-Landschaft und wie diese leistungsstarken Tools Ihr Unternehmen voranbringen können.

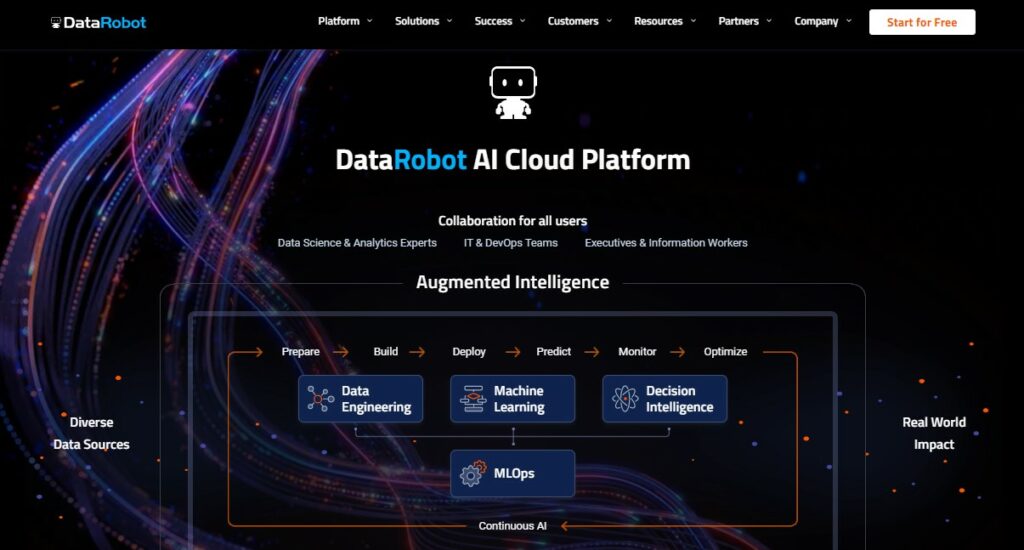

1. DataRobot

AI Cloud ist eine neue Anwendung, die für die Anforderungen, Herausforderungen und den Komfort der heutigen KI entwickelt wurde. Darüber hinaus verändert KI jede Branche und Organisation. Im weiteren Verlauf werden Ergebnisse, die auf maschinellem Lernen basieren, zum neuen Standard.

Um das Ultimatum der modernen Welt zu erfüllen, müssen wir schnelles, gemeinsames Handeln demonstrieren und Ihre KI-Lösungen im gesamten Unternehmen beschleunigen. Daher autorisiert die Lösung für automatisiertes maschinelles Lernen (AutoML) von DataRobot KI-Ersteller in vielen Verwaltungen, ihre Bereichskompetenz anzuwenden und optimale Modelle zu liefern, ohne Zeit und Vertrauen zu verlieren.

Die DataRobot AI Cloud ermöglicht es Ihnen, aus spektakulär vielfältigen Datentypen erfindungsreiche neue Modelle zu verbessern. Es enthält ein riesiges Informationszentrum von Open-Source- und Rentabilitätsmodellen, von klassischer Retrogradation und komplexer multinomialer Klassifikation bis hin zu den neuesten tiefstrukturierten Lernalgorithmen.

Zunächst können Daten aus beliebigen Quellen, von lang etablierten tabellarischen Daten und Rohtexten bis hin zu okularen und geopolitischen, erfasst werden.

• Konfigurieren Sie Datenbankverbindungen über ein „Self-Service“-JDBC-System.

• Verwenden Sie den AI-Katalog, um Ihre Datensätze zu aktualisieren und zu filtern.

• Führen Sie Feature Exploration auf mehreren transformierten primären Datensätzen durch.

• Untersuchen Sie Daten anhand von Berichten und visuellen Darstellungen.

• Integrieren Sie nach Bedarf eine Reihe miteinander verbundener Datenverarbeitungsschritte, um Frameworks mit neuen Daten zu trainieren.

2. Dataiku

Dataiku ist eine der robustesten und umfassendsten Data-Science- und ML-Lösungen, die es zahlreichen Organisationseinheiten ermöglicht, alle KI-basierten Anwendungen einfach und sicher zu implementieren, zu entwerfen und zu betreiben.

Nun, die rasche Intensivierung des aus Daten gewonnenen Bewusstseins ist analytisch für den Fortschritt der Entwicklung Unternehmens-KI, und es geht um die Eskalation – die Verwendung zugänglicherer Daten für zahlreiche Datenprojekte. Dies kann nicht geschehen, ohne die Zahl der Personen zu erhöhen, die regelmäßig auf Daten zugreifen und mit ihnen arbeiten (es ist auch wichtig zu beachten, dass dies nicht ohne erhebliche Unterstützung, nämlich den nicht-kodierenden Analysten, der eine größere Rolle übernimmt, geschehen kann).

Dataiku bietet diese enormen Eigenschaften – durch die qualitative Analyse der Vision können Datenanalysten problemlos verschiedene Arten von Daten recherchieren, erstellen, verbessern und Lösungen finden, einschließlich strukturierter und nicht strukturierter Daten (übrigens Vergangenheitsdaten – das ist so). authentischer als Tabellenblätter). Auch die Wissenschaftler, die in Dataiku an der Datenerfassung gearbeitet haben, durch Programmierung und Gadgets, die am besten geeignet sind – Darüber hinaus ist die Zusammenarbeit bei Datenprojekten durchaus lohnenswert.

• Der erste Schritt besteht darin, Datasets zu definieren, die eine Verbindung zu Ihren Datenquellen herstellen.

• DSS ermöglicht es Ihnen, Ihre Daten unmittelbar nach der Definition eines Datensatzes anzuzeigen.

• Die visuelle Datenaufbereitung in DSS ermöglicht die visuelle und interaktive Erstellung von Datenfiltern und -vorverarbeitungen.

• Zweitens bietet es eine personalisierte Funktionalität für die explorative Datenanalyse (EDA) von Datensätzen.

• Schließlich wird maschinelles Lernen eingesetzt, wenn versucht wird, eine Zielvariable vorherzusagen.

3. H20

Bei H2O.ai ist die Demokratisierung von KI nicht nur ein Design. Es ist eine Bewegung. Und das bedeutet, dass es Maßnahmen braucht. Ursprünglich begann es als eine Gruppe gleichgesinnter Personen im offenen Bereich, die von der Idee getragen wurden, dass es Freiheit bei der Herstellung und Nutzung von KI geben sollte.

H2O ist ein vollständig Open-Source-Framework für verteiltes ML mit sequenzieller Skalierbarkeit. H2O verstärkte die unterschiedlichsten statistischen Methoden des maschinellen Lernens, einschließlich Gradientenverstärkung, SVMs und Deep-Learning-Techniken. Darüber hinaus konzentriert es sich vollständig auf die Automatisierung der schwierigsten produktiven Aktivitäten in den Bereichen Datenwissenschaft, einschließlich Merkmalsextraktion, Optimierung und Modellimplementierung. Darüber hinaus ermöglicht die Integration fahrerloser KI Dateningenieuren aller Erfahrungsstufen, Framework-Pipelines bequem über die GUI zu testen und zu implementieren. Daher,

H2O ermöglicht es Benutzern, die Raffinesse der Entwicklung modernster Methoden zu nutzen und die Attribute zu personalisieren, die Verbraucher zum Extrahieren und Implementieren ihrer Daten benötigen, und unterstützt so Benutzer und Feldexperten bei der Teilnahme an der KI-Revolution.

• H2O bietet ein R-Paket, das von CRAN geladen werden kann, und ein Python-Paket, das von PyPI abgerufen werden kann.

• Fügen Sie die Komponenten H2O und GBM hinzu.

• Importieren Sie den Datensatz, der für Klassifizierungsaufgaben verwendet wird.

• Den Datensatz in zwei Sätze umwandeln (Training und Test)

• Modell trainieren

• Ausgabe der AUC-Scores für Trainings- bzw. Validierungsdaten.

4. Qlik

Qlik ist einer der führenden Anbieter KI-Datenanalyse-Tools das KI- und maschinelle Lerntechnologien nutzt, um intelligente Datenanalysen für Unternehmen jeder Größe bereitzustellen.

Mit Hilfe von Qlik AutoML sind Analyseteams in der Lage, schnell Modelle für maschinelles Lernen für prädiktive Analysen und Was-wäre-wenn-Szenarioanalysen zu generieren.

Mit einer einfachen, codefreien Erfahrung können Sie schnell Modelle erstellen, Prognosen erstellen und Geschäftsszenarien testen. Verbinden Sie Ihre Daten schnell und finden Sie wichtige Treiber für die Erstellung und Verfeinerung von Modellen für maschinelles Lernen.

Erstellen Sie mit vollständig erklärbaren Daten Prognosen und testen Sie Was-wäre-wenn-Szenarien. Und für eine vollständig interaktive Analyse geben Sie die Ergebnisse sofort frei oder verbinden Sie Modelle sofort mit Qlik Sense.

Datenintegration bereitstellen:

Ob Qlik oder Tableau, Power BI und mehr, jede Analyseplattform kann von DataOps profitieren; unsere Qlik Data Integration beschleunigt die Suche und Bereitstellung von analysebereiten Echtzeitdaten durch die Automatisierung von Datenstreaming, Verfeinerung, Katalogisierung und Veröffentlichung in jeder Cloud.

Unterstützung bei der Datenanalyse:

Nutzen Sie moderne, maschinell lernende Cloud-Analysen, um Ihren gesamten Mitarbeitern zu ermöglichen, jeden Tag bessere Erkenntnisse und bessere Entscheidungen zu treffen, damit Sie Ihr Unternehmen revolutionieren und zum Marktführer werden können.

5. Akki

AutoML von Akkio ist ein Tool, das es nicht-technischen Experten ermöglicht, KI für Aufgaben wie Fluktuationsrate, Betrugsprävention und Vertriebspipeline-Optimierung schnell zu erstellen und zu implementieren, ohne Code schreiben zu müssen. Akkio kündigte 2020 seine No-Code-Plattform für maschinelles Lernen an, die es jedem ermöglicht, Modelle in erheblich kürzerer Zeit zu entwerfen und zu implementieren. Darüber hinaus trainiert Akkio mit statistischen Daten ein personalisiertes maschinelles Lernmodell und integriert es, um intelligente Entscheidungen in Echtzeit zu treffen.

• Zunächst wird es mit den Daten verknüpft, da Daten die Hauptquelle des ML-Modells sind.

• Außerdem handelt es sich um ein tabellenbasiertes KI-Tool, sodass statistische Daten erforderlich sind (z. B. eine Tabellenkalkulation oder eine CSV-Datei). Daher erkennt Akkio automatisch die Datentypen innerhalb des Datensatzes. Zum Beispiel Text, ID, Nummer oder Kategorie.

• Flow Explorer ist ein vollständiges KI-Modell von der Datenquelle bis zur Modellimplementierung. Es kann als visuelle Schnittstelle zum Verbinden von Daten, zum Entwerfen eines KI-Modells und zum Implementieren ohne Code integriert werden.

• Schließlich kann das Training entscheiden, was zahlreiche Auswahlmöglichkeiten bietet (z. B. schnellste, hohe Qualität und höchste Qualität).

6. Neuton.AI

Neuton ist ein neuartiges Modell, das deutlich schneller und robuster ist und weniger Fähigkeiten und Training erfordert als andere, die von den digitalen Giganten Facebook, Google und AWS angeboten werden. Darüber hinaus ermöglicht es Benutzern, die Modellqualität aus verschiedenen Blickwinkeln zu bewerten und Vorhersageergebnisse zu analysieren.

Der Neuton Auto ML umfasst drei einfache Schritte:

• Erfasste Daten für das Training

Zunächst beginnt der Modellerstellungsprozess mit dem Hinzufügen einer neuen Lösung, die den Entwurf eines Modells ermöglicht und Vorhersagen generiert, indem neue Daten übergeben und Modellparameter definiert werden.

• Trainieren Sie Ihr Modell

Eine virtuelle Maschine wird sofort beschafft, um Daten-Denoising, Merkmalsextraktion, Modelltraining und Validierung durchzuführen. Dieses Verfahren ist vollständig automatisiert und erfordert keine Eingaben oder Eingriffe des Benutzers.

Der Neuton kann anhand der Werte der Eingangsvariablen automatisch die Aktivitätsart bestimmen. Wenn Neuton beispielsweise eine binärbasierte Klassifizierung eines Aktivitätstyps erkennt, können wir sie nicht in einen anderen Aktivitätstyp umwandeln. Wenn Neuton andererseits eine Mehrklassenklassifikation erkennt, können wir sie leicht in die Regression verschieben oder umgekehrt.

• Voraussagen machen

Basierend auf Informationen aus dem Rahmenrelevanzindikator berechnet dieses Kriterium die historische Korrelation über die Zeit zwischen den für das Modelltraining verwendeten Daten und allen Daten, die für Vorhersagen übertragen werden.

7. Punktdaten

dotData ist ein leistungsstarkes AutoML-Tool, das dabei hilft, den gesamten Zyklus von Projekten in den Bereichen Data Science, maschinelles Lernen und künstliche Intelligenz durch einen vierstufigen Zyklus zu automatisieren: Beschleunigung, Erweiterung, Demokratisierung und Operationalisierung, und einen höheren Geschäftswert liefert.

Beschleunigung: dotData befreit Data Scientists von der Monotonie einfacher manueller Aufgaben und gibt ihnen die Freiheit, Probleme zu lösen und zehnmal mehr Projekte zu liefern.

Erweiterung: Künstliche Intelligenz in diesen Daten erweitert das Fachwissen des Datenwissenschaftlers. Die KI-Engine untersucht Millionen von Hypothesen und hilft, tiefere Geschäftseinblicke zu finden.

Demokratisierung: dotData demokratisiert ein Projekt und macht es einfacher, die Macht dieses Projekts in die Hände von mehr Benutzern zu legen. So entsteht eine wirklich datengetriebene Kultur, die nicht nur für eine einzelne Gruppe ist.

Operationalisierung: Schließlich ermöglicht dotData eine schnellere Data-Science-Operationalisierung. Es bringt ein Data-Science-Projekt direkt vom Labor zum Unternehmen.

8. Impira

Impira ist ein weiteres leistungsstarkes AutoML-Tool, das mithilfe von künstlicher Intelligenz und maschineller Lerntechnologie automatisch saubere, nutzbare Daten aus Dokumenten wie Antragsformularen, Bestellungen und Rechnungen extrahieren kann. Es ist auch sehr nützlich bei der Massendateianalyse oder der Informationsdatenrecherche. Das Tool erfordert keine weitere Codierung. Alles ist vorinstalliert. Jedes Geschäft oder Unternehmen kann dieses fortschrittliche Automatisierungstool verwenden, ohne ein einziges Codeskript schreiben zu müssen, um sein Geschäft zu automatisieren.

Impira verwendet Natural Language Processing (NLP) und Computer Vision (CV) zur Datenextraktion. Das Tool ist das erste, das eine Lösung für Geschäfts- und Unternehmensanwender bietet, um maschinelle Lernalgorithmen zu trainieren, um Dokumente wie Rechnungen und PDFs zu scannen und wichtige Daten in Tabellenkalkulationen und anderen digitalen Tools für die Verwendung in verschiedenen Systemen und Software zu speichern.

Die großartige Benutzererfahrung, die übersichtliche Benutzeroberfläche und die benutzerfreundlichen Funktionen haben Imperia zu einem der beliebtesten AutoML-Tools gemacht.

9. PyCaret

PyCaret ist eine bekannte Open-Source- und Low-Code-Bibliothek für maschinelles Lernen in Python, die zur Automatisierung von Arbeitsabläufen für maschinelles Lernen und von Modellen der künstlichen Intelligenz (AutoML) verwendet wird. Es ermöglicht dem Benutzer, ein maschinelles Lernmodell in einer Low-Code-Umgebung zu trainieren und bereitzustellen. Die Bibliothek ist sehr hilfreich, um das Tempo des Experimentzyklus exponentiell zu erhöhen, den Benutzer produktiver zu machen und Modelle mit nur wenigen Codeskripten auf einem bereitgestellten Datensatz zu vergleichen, zu bewerten und abzustimmen. Daher tragen dieses durchgängige maschinelle Lernen und eine Modellverwaltungsbibliothek dazu bei, die Produktivität und Effizienz auf die nächste Stufe zu heben.

Zu den Funktionen dieses automatisierten Tools für maschinelles Lernen gehören Modelltraining, Datenaufbereitung, Hyperparameter-Tuning, Interpretierbarkeit, Analyse und viele andere.

PyCaret macht das Leben eines Datenwissenschaftlers einfacher.

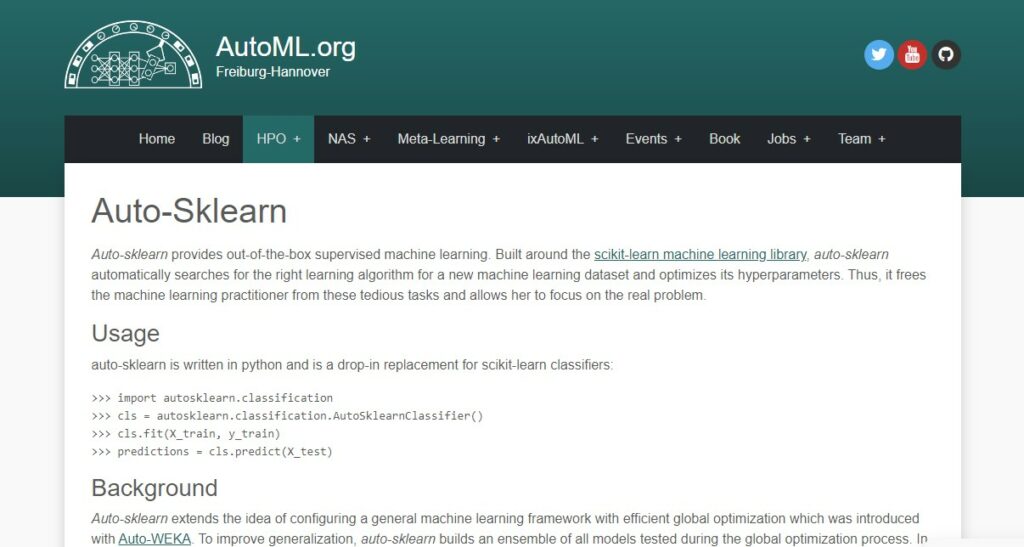

10 Auto-SKLearn

Auto-SKLearn ist eine leistungsstarke Python-Bibliothek für überwachtes maschinelles Lernen. Es sucht automatisch nach dem richtigen Machine-Learning-Algorithmus für einen neuen Machine-Learning-Datensatz und optimiert dessen Hyperparameter. Es basiert auf der maschinellen Lernbibliothek von scikit learn.

Die Bibliothek ist im maschinellen Lernen und in der Datenwissenschaft ziemlich berühmt geworden, da sie den gesamten Vorgang der Suche nach dem geeigneten maschinellen Lernalgorithmus für einen neuen maschinellen Lerndatensatz und die Optimierung seiner Hyperparameter automatisiert. Mit Hilfe dieses Tools kann der gesamte Vorgang jetzt mit nur wenigen Klicks erledigt werden.

Data Scientists verwenden es gerne, da es sie von mühsamen Aufgaben befreit und es ihnen ermöglicht, sich auf das eigentliche Problem zu konzentrieren.

11 BigML

BigML ist eine praktische, benutzerfreundliche Plattform für Aufgaben des maschinellen Lernens. Es ist ein verbrauchbares, skalierbares und programmierbares ML-Tool, mit dem Aufgaben wie Regression, Klassifizierung, Zeitreihenvorhersage, Anomalieerkennung, Clusteranalyse, Themenmodellierung und Assoziationserkennung einfach und leicht gelöst und automatisiert werden können.

Das Tool wurde bereits 2011 gegründet. Und ist aufgrund seiner außergewöhnlichen Eigenschaften sehr berühmt geworden.

Das Tool bietet eine große Auswahl an kostenlosen Datensätzen zum Spielen. Es hat fast alle Machine-Learning-Algorithmen implementiert, die mit der leicht zugänglichen API bedenkenlos on-the-fly verwendet werden können, und die Algorithmen sind auch optimiert. Es ist superschnell und effizient. Ein weiterer Vorteil ist, dass der Benutzer keinen lokalen Speicherplatz benötigt. Es funktioniert auf Cloud- und Web-API.

12 RapidMiner

RapidMiner ist ein erstaunliches Data-Mining-Tool, das alles an einem einzigen Ort bereitstellt, von Data Mining bis hin zu Modellbereitstellung und Modellbetrieb. Das Tool kann einige der erstaunlichsten Anwendungsfälle für maschinelles Lernen und Deep Learning mit nur wenigen Klicks lösen. Es ermöglicht den Benutzern, mehrere statistische Analysen, maschinelle Lernmodelle und EDA auf derselben Plattform durchzuführen. Außerdem bietet es eine Vielzahl von Plugins zur Integration und ist mit Android- und iOS-Systemen kompatibel.

RapidMiner hilft auch beim Modelloptimierungsmodell-Umschulungsansatz, und es gibt eine sogenannte Driftmodellierung, die mit Hilfe dieses leistungsstarken Tools möglich ist.

Es verfügt über erstaunliche Funktionen wie Kreuzvalidierung, visuellen Prozessablauf, ein umfassendes Set aktueller Analysewerkzeuge und Schieberegler für das Szenario, bekannt als Was-wäre-wenn-Analysen.

13 Google Cloud AutoML

Trotz der Tatsache, dass die Abteilung für AutoML ungefähr ein Jahr alt ist (einschließlich Open-Source-AutoML-Bibliotheken, Workshops, Experimenten und Wettbewerben), hat Google 2017 den Begriff AutoML für seine Neural Network-Forschung übernommen.

Googles Cloud AutoML wurde im Januar 2018 als eine Reihe von Produkten für maschinelles Lernen angekündigt. Bis zu diesem Punkt besteht es aus einem offen verfügbaren Element, AutoML Vision, einer API, die Objekte in Bildern erkennt oder verknüpft. Gemäß diesem Konzept hängt Cloud AutoML Vision von zwei zentralen und grundlegenden Techniken ab: Transfer Learning und Perceptual Architecture Search. Es ermöglicht Entwicklern mit den geringsten Kenntnissen im maschinellen Lernen, erweiterte Modelle zu erstellen, die auf ihre Bedürfnisse zugeschnitten sind. Darüber hinaus beinhaltet es die Fähigkeit, als Teil der zentralisierten ML-Plattform von Google, Vertex AI, verschiedene Modelle ausnahmslos mit räumlichen und textuellen Daten zu trainieren.

• Google Cloud AutoML geht in eine ungekürzte und nicht identische Phase über und ist speziell auf Googles kampferprobten, faktenkonformen, tiefgreifenden neuronalen Netzwerken für Ihr getaggtes Material aufgebaut.

• Als Ersatz dafür, beim Testen von Modellen aus Ihren Daten von der Linie zu beginnen, bietet Google Cloud AutoML automatisches Deep-Transfer-Lernen und CNN-Modellsuche (was bedeutet, dass es die aufrechte Einbindung zusätzlicher Netzwerkschichten sucht) für Sprachsatzübertragung, NLP-Klassifizierung und Bilderkennung.

14 Splunk

Splunk ist ein Tool zum Verfolgen und Durchsuchen großer Datenmengen. Es indiziert und vergleicht Daten in einem durchsuchbaren Container und ermöglicht das Generieren von Warnungen, Berichten und Visualisierungen. Bei geschäftlichen Schwierigkeiten wie IT-Management, Sicherheit und Compliance kann es Datentrends erkennen, Metriken entwickeln und bei der Diagnose von Problemen helfen.

Verwendung von Splunk für maschinelles Datenlernen:

Splunk unterstützt Unternehmen beim Abrufen von Daten aus Serverdaten. Dies macht die Anwendungsverwaltung, das IT-Betriebsmanagement, die Compliance und die Sicherheitsüberwachung effizienter.

Splunk-Analyse:

Splunk basiert auf einem Algorithmus, der große Datenmengen sammelt, indiziert und verarbeitet. Jeden Tag kann es Terabytes an Daten in jedem Format verarbeiten. Splunk analysiert Daten in Echtzeit und erstellt nach Bedarf Schemata, sodass Unternehmen eine Reihe abfragen können, ohne zuvor ihre Struktur zu verstehen. Es ist einfach, die Daten in Splunk zu importieren und sofort mit der Analyse zu beginnen.

Splunk kann auf einem einzelnen Computer oder in der riesigen, verteilten Architektur eines Unternehmensrechenzentrums installiert werden. Es bietet ein Maschinendatennetzwerk, das Forwarder, Indexer und Suchköpfe umfasst und die Echtzeiterfassung und -verarbeitung von Daten aus beliebigen Netzwerken, Rechenzentren oder IT-Umgebungen ermöglicht.

15 Amazon Lex

Amazon Lex ist eine Lösung zur Integration sprach- und textbasierter virtueller Assistenten in beliebige Anwendungen. Bietet leistungsstarke Deep-Learning-Funktionen wie automatische Spracherkennung und Natural Language Understanding für die Erkennung von Textabsichten, sodass Kunden Lösungen erstellen können, die ein hochgradig interaktives Verbrauchererlebnis und realistische Gesprächsinteraktionen bieten.

Amazon Lex-Nutzung:

Amazon Lex ist ein Text- und Sprachverarbeitungsdienst. Entwickler können diese Funktionen über eine einfache und klare Schnittstelle nutzen, die äußerst einfach ist. Sie können in kurzer Zeit von Grund auf zu einem voll funktionsfähigen Chatbot-System wechseln. Setups für komplexere Chatbots können länger dauern.

Mit einer Kombination aus Aliasen und Versionierung bietet Amazon Lex Bereitstellungsmechanismen, mit denen Sie Ihre Konversationsschnittstellen schnell und einfach in zahlreichen Umgebungen einführen können. Da Amazon Lex keine Bandbreitenbeschränkungen vorschreibt, können Sie skalieren, ohne sich Gedanken über die Bandbreite machen zu müssen. Schließlich arbeitet Amazon Lex mit mehreren anderen AWS-Diensten zusammen.

Kommerzielle Verwendung von Amazon Lex:

Einige der folgenden kommerziellen Anwendungsfälle können mit Amazon Lex implementiert werden. Sie können das Abendessen mit dem Commerce ChatBot bestellen. Mit dem Enterprise ChatBot können Sie eine Verbindung zu Datenressourcen der Organisation herstellen. Support ChatBot bietet automatisierten Kundenservice und Antworten auf häufig gestellte Fragen.

16 Tazi KI

Tazi.ai ist eine bekannte AutoML-Lösung für kontinuierliches maschinelles Lernen mit Echtzeitdaten und Menschen, die leicht verständlich ist. Es ermöglicht Experten der Unternehmensdomäne, mithilfe von maschinellem Lernen Prognosen zu erstellen. Tazi.ai ist ein Produkt-Startup für maschinelles Lernen, das sich auf das Geschäft konzentriert. Es bietet skalierbare und zuverlässige Dienste und Lösungen für maschinelles Lernen, um sowohl Stream- als auch Batch-Daten zu verarbeiten.

Tazi bietet verantwortungsvolle KI:

Tazi vertraut auf verantwortungsbewusste KI. Dies ist sowohl im Plattformdesign als auch in der Betriebsphilosophie verankert. Ein solides Geschäft basiert auf Daten und einer effektiven Entscheidungsfindung auf der Grundlage dieser Daten. Tazi glaubt, dass jeder von seinem System profitieren kann, um bessere Entscheidungen zu treffen. Tazi ist eine Moderatorin. Menschen treffen Entscheidungen. Sie streben danach, durch den Einsatz von KI einen positiven Einfluss auf die Gesellschaft auszuüben.

Menschenbasiertes maschinelles Lernen:

Tazi wurde mit Blick auf den Benutzer erstellt. Es ist menschenzentriert und strebt danach, allen Menschen maschinelles Lernen zu ermöglichen. Sie glauben, dass maschinelles Lernen auf transparente Weise in die Gesellschaft integriert werden sollte. Sie stellen sich maschinelles Lernen als Mitarbeiter, Kollaborateur und vertrauenswürdigen Berater neben Menschen vor.

Maschinelles Lernen ist letztlich menschenzentriert. Die Demokratisierung der KI ist Tazis erster Schritt zur Schaffung dieser menschenzentrierten KI. Die Plattform ermöglicht es Geschäftsexperten derzeit dank benutzerfreundlicher Schnittstellen und interaktiver Erklärungen, Lösungen für maschinelles Lernen zu überwachen, zu erstellen und einzusetzen.

17 MLJAR

MLJAR – das Programm für automatisiertes maschinelles Lernen – hilft bei der Problemlösung, indem verschiedene Kombinationen von maschinellen Lernalgorithmen überprüft werden. Statistische Algorithmen regeln den automatisierten maschinellen Lernprozess.

Mit umfassendem Feature-Engineering, Auswahl und Optimierung von Algorithmen, automatischer Dokumentation und Erläuterungen zum maschinellen Lernen erstellt MLJAR eine vollständige Pipeline.

Hilfe beim Erstellen besserer ML-Modelle:

Alle Modelle und Analyseergebnisse werden standardmäßig im ausgewählten Verzeichnis des großen Automated Exploratory Data Analysis (AutoEDA)-Frameworks gespeichert. Frühzeitiges Stoppen ermöglicht es Ihnen, das Trainingsmodell genau dann anzuhalten, wenn es erforderlich ist, um eine Überanpassung zu vermeiden.

Alle Ihre Modellinformationen sollten an einem Ort aufbewahrt werden. Speichern Sie die Konfiguration von Hyperparametern, Validierungsansatz, optimierter Metrik und Lernzeit.

18 Schnecken-KI

Auger.AI ist der effektivste Weg, um sicherzustellen, dass maschinelle Lernmodelle genau sind. Das Tool MLRAM (Machine Learning Review and Monitoring) stellt sicher, dass Ihre Modelle immer korrekt sind. Es berechnet sogar die Kapitalrendite Ihres Vorhersagemodells!

Sowohl Datenanalysten als auch Geschäftsanwender werden von MLRAM profitieren. Es verfügt über Funktionen wie Diagramme zur Genauigkeitsvisualisierung und Leistungswarnungen. Erkennungssysteme und optimales automatisiertes Nachtrainieren sind ebenfalls möglich. Das Verbinden Ihres Vorhersagemodells mit MLRAM erfordert nur eine Codezeile.

Automatische Datenvorverarbeitung:

Auger durchläuft einige grundlegende Vorverarbeitungsverfahren, wenn ein Benutzer eine CSV-Datei mit Testdaten einreicht. Es erkennt Datenformate und einige grundlegende Informationen zu jedem Merkmal (Datenbankfeld), wie z. B. Bereiche und eindeutige Werte, sowie eine grafische Darstellung der Verteilung.

Dies trägt dazu bei, die Leistung zu beschleunigen, da die Engine nicht mehr auf irrelevante Attribute testen muss und Ausreißer entfernt werden, die die Leistung eines Modells verzerren und zu falschen Ergebnissen führen könnten.

19 JADBio AutoML

JADBio automatisiert die maschinelle Lernauswertung, die in jeder Disziplin hervorragende Voraussetzungen schafft, indem es jedem ermöglicht, unabhängig von seinem Kompetenzniveau Wahrnehmungen aus seinen Daten zu extrahieren, was die Produktivität und Ergebnisse der Experten enorm optimiert.

Das Framework ist ein komplexer Satz von Algorithmen und hochmodernen Tools, die es Experten ermöglichen, ihre Aufgaben schneller und mit geringerem Zeitaufwand zu erledigen. Darüber hinaus wurde es von Datenexperten und Analysten entwickelt, und obwohl es mit jeder Datenklassifizierung ausprobiert werden kann, ist es speziell für die Biologie (Menschen, Tiere, Pflanzen usw.) konzipiert.

Das bedeutet, dass es preisgünstigen Stichprobengrößen mit großen Eigenschaften von Sets helfen kann; Es kann die Existenz von Mengen vorhersagen und bietet mehrere Modelle mit vergleichbarem Vorhersagepotential, aber mit unterschiedlichen Merkmalen.

JADBio entwickelt und bringt ein AutoML-System auf den Markt, ein müheloses Tool zum Scannen molekularer, biologischer und biomedizinischer Daten.

Zunächst fügt JADBio Ihrer zweidimensionalen Datenmatrix automatisch einen Merkmalstyp hinzu. Dies ist von entscheidender Bedeutung, da je nach Feature-Typ eine bestimmte ML-Aktivität ausgeführt wird, wenn dieses Feature als Ausgabe ausgewählt wird.

Indem die Verwendung von Merkmalsauswahlalgorithmen vorgeschrieben wird, verwenden Modelle nur die optimalen Merkmale. Dies weist darauf hin, dass Modelle, die alle Merkmale des Datensatzes verwenden, nicht berücksichtigt werden.

Mit JADBio können Sie Optimierungsaufwand und Ressourcenverbrauch konfigurieren und eine eindeutige Kennung für Ihre Analyse generieren, die Sie ändern können.

Abschließende Worte zu AutoML-Tools

Automatisiertes maschinelles Lernen oder AutoML ist eine maschinelle Lerntaktik zum Erstellen von Modellen, ohne sich um zeitaufwändige Dinge wie die Auswahl von Hyperparametern oder einzelnen Modellen kümmern zu müssen. Der Data Scientist oder der Machine Learning Praktiker kann sich also auf die Lösung der Hauptprobleme konzentrieren.

AutoML-Plattformen erfordern keine Programmierung, während einige AutoML-Bibliotheken möglicherweise nur einmal einige Codezeilen benötigen.

AutoML-Tools helfen bei der Automatisierung manueller Aufgaben, um die Produktivität von ML-Modellen zu steigern und die Projektgeschwindigkeit exponentiell zu steigern.

Es gibt viele verschiedene Arten von AutoML-Tools und -Software auf dem Markt.

Die Tools arbeiten mit unterschiedlichen Algorithmen, und auch ihr Arbeitsprinzip variiert. Die Wahl der Verwendung eines bestimmten Tools hängt von der Art und den Anforderungen Ihrer Arbeit ab.

In der modernen Zeit, in der die Daten schnell generiert werden, kann es fatal sein, auch nur eine einzige Sekunde zu verschwenden. Dennoch hat Automated Machine Learning (AutoML) das Spiel verändert, indem es leistungsstarke Algorithmen bereitstellt, die nur einen einzigen Klick benötigen, um die Arbeit zu erledigen. Mit einem Klick können Sie Ihr AutoML-Modell trainieren.

Patryk Miszczak